AI面试官要取代人类了?图像生成器的缺陷,难道是源于欧美国家对于我们亚洲文明根深蒂固的偏见?大语言模型和人类比起来原来是鼠目寸光吗?

五一劳动节即将到来,预祝各位小伙伴劳动节快乐!让我们看看近期AI界有什么有趣的事吧!

1. AI面试官:招聘界的新宠儿

在招聘领域,AI技术正以其独特的魅力和能力,逐渐成为面试官的新宠儿。AI面试官的出现,不仅改变了传统的面试流程,还为求职者和招聘方带来了全新的体验。

许多大学生都纷纷在社交平台上分享自己遇到的AI面试的经历,有人吐槽“感觉和AI面试官没有任何互动”,“猜不透AI到底想要什么,感觉自己被刷的莫名其妙”,也有人表示认可“感觉AI面试至少是对所有候选人是公平的,不会出现面试官主观的偏见偏差、个人因素等问题”。

看了今年春招后的各种面试问题,小编也感觉好像关于AI面试的话题一年比一年多,甚至还出现了不少专门针对AI面试的培训。

AI面试给招聘者带来的便利是毋庸置疑的,曾经有个段子说,HR收到了一堆简历后,将手中简历往天上一丢,只有最先落地的简历的应聘者才有资格参与面试。实际上反映的就是面试工作需要花费巨大的人力成本,然而很多面试官工作内容并不复杂,甚至到后面有一些机械。不管面试者说啥,面试官都是在固定重复问几个问题。这种有标准问题和评估回答的工作,不正是AI最擅长的吗?

但是,AI面试真的靠谱吗?

目前的一些AI面试,除了对面试者的回答进行评价,用以判断其职业能力以外,也会通过面试者的表情、动作等等进行评价,用来判断其心理素质和沟通能力等。最终会以类似人物画像和能力评分的形式提供到人类面试官手中,再进行批量筛选。

但是AI可能无法完全理解人类的情感和非语言交流,这可能导致对候选人某些重要能力的评估不足。这也就体现出一些同学的疑惑“不知道自己是怎么被刷掉的”。

实际上,据小编了解,AI面试目前仍属于小众赛道,采用的公司并不多。一是因为每年招聘人数没有达到一定量级的公司,没有AI面试的需求,二是因为当前AI系统仍然无法达到真正招聘专家的经验水平,对于一些重要的职位,还是得依靠有经验的人类面试官来把关。

因此,目前一些大厂们使用AI面试,往往都是应用于某些职位面临大量应聘者时的初筛上,很显然,校招这一场景就非常适合使用AI面试,这也正是为什么在某些特定的时间段就能看到AI面试的话题增多。

当然,不难预测,未来AI面试系统将更会加智能化,比如能够根据面试官的要求自动生成面试方案,甚至提供薪资谈判的建议。但是,人进入公司后最终仍然是和人打交道,而非AI,因此小编认为,如果一个企业的招聘工作完全自动化,最终招进来的人恐怕也未必能尽如人意。

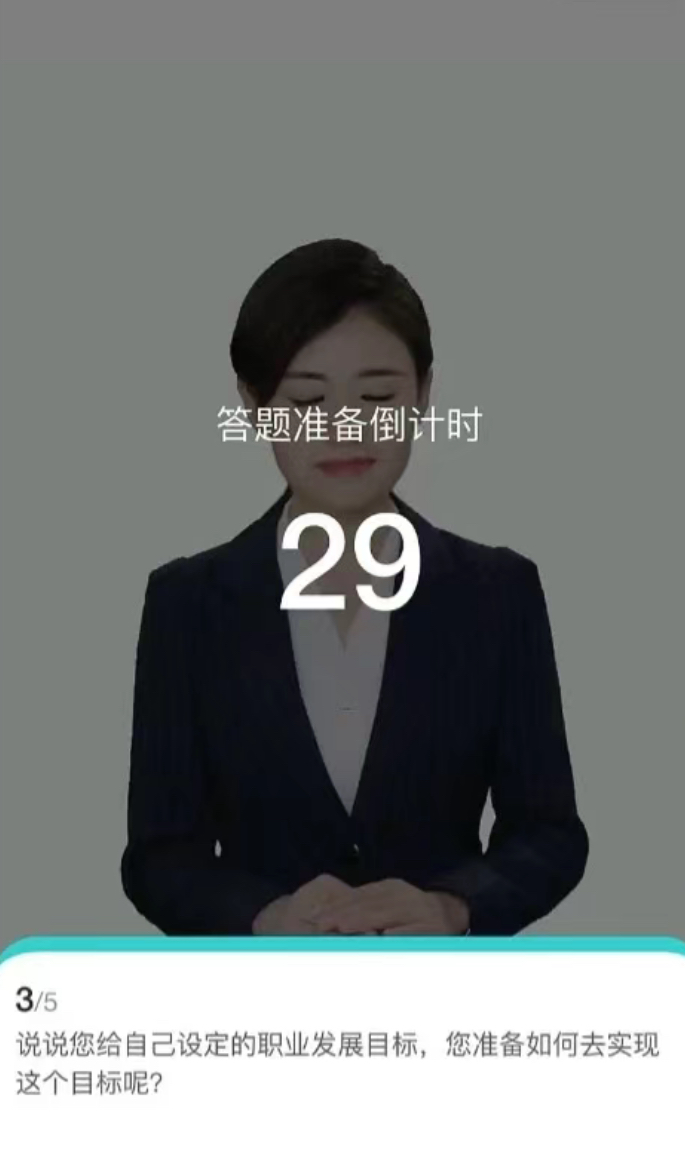

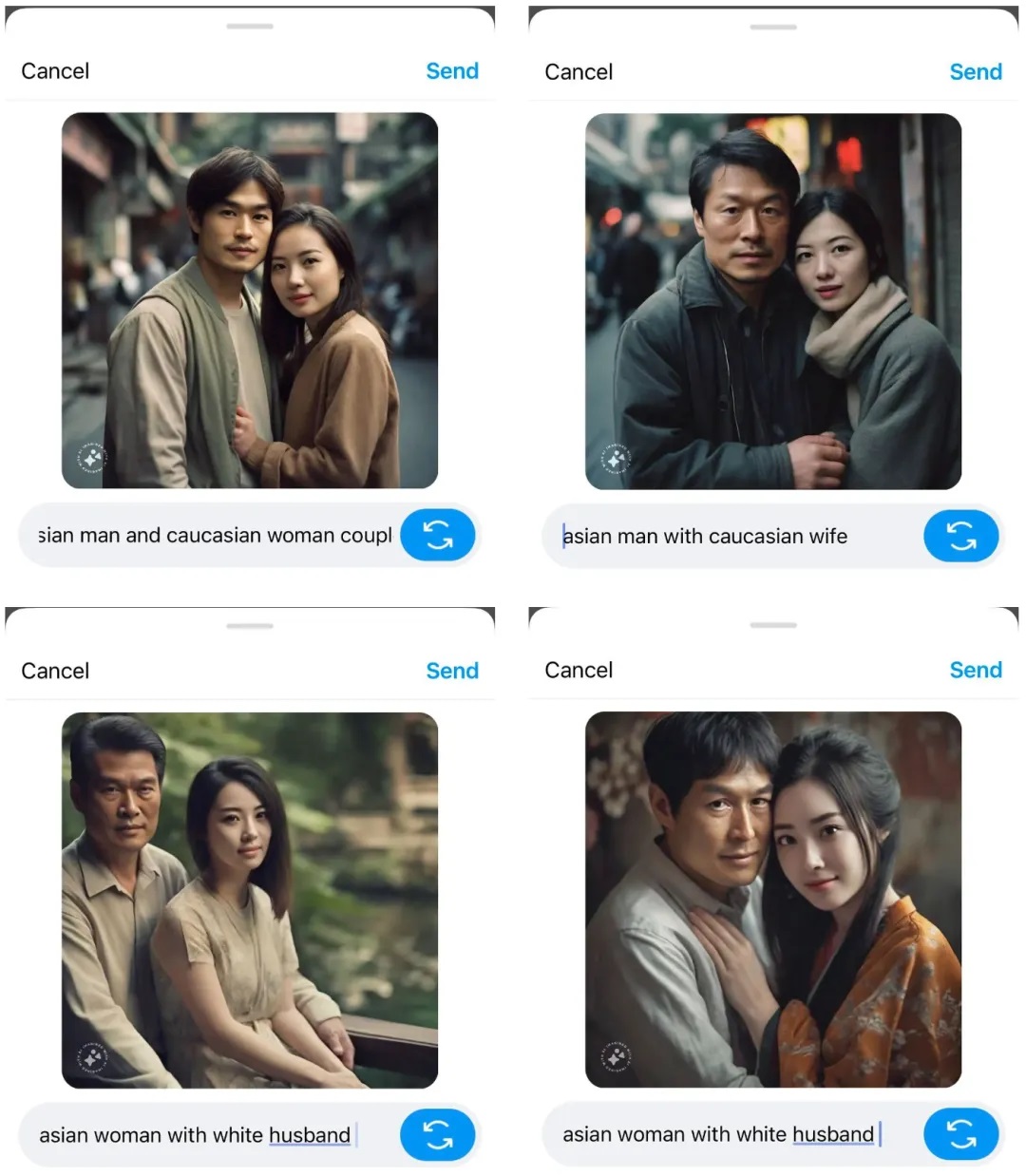

2. Meta图像生成器的「歧视」

近日,外媒 The Verge 的一篇文章指出,Meta 的 AI 图像生成器表现出某种偏见,无法准确生成「亚洲男性和白人妻子」或者「亚洲女性和白人丈夫」这类图像。他们尝试了部分亚洲男女性和白人异性的提示词,试图让Meta图像生成器生成对应的图像,然而Meta在多数情况下都无法遵照提示词来生成,无论怎样调整文本提示,生成的图像大多是两个亚洲人,而不是预期的跨种族组合。

在没有明确提示的情况下,该工具还会给南亚女性添加纱丽等特定文化服饰,显示出了对亚洲人群的刻板印象。

在了解到这个消息后,小编也去试了下,意外地发现,Meta已经可以生成亚洲男性和白人女性的结婚照片了,虽然并不是完全准确,但至少不像The Verge说的那样完全无法生成。

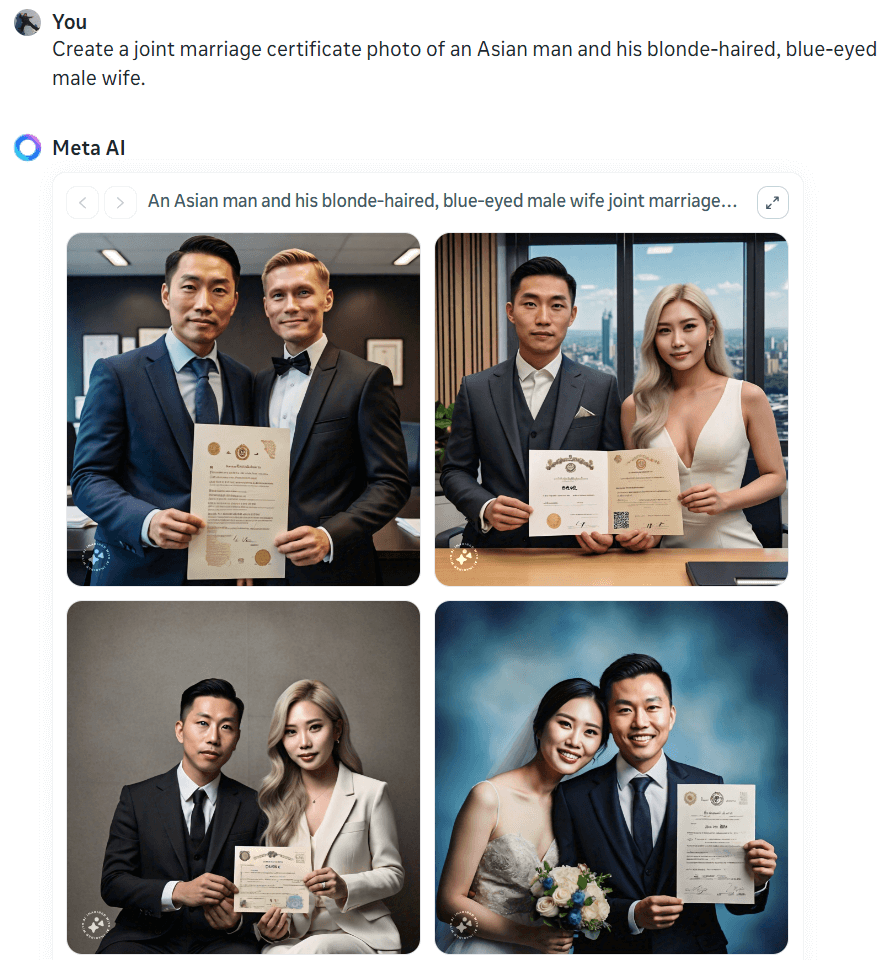

但与此同时,小编又做了一些大胆的尝试,发现Meta似乎又对LGBT群体存在一定程度上的偏见,比如下图,提示词要求AI生成两个男性的结婚照片,但是4张图片中只有一张图片是满足条件的。

有网友分析称,这是Meta在训练的时候没有喂给模型这一场景足够的示例。小编对此观点并不是十分赞同。小编认为,未必是因为训练数据不足,反而是因为训练数据本身就带有偏见。

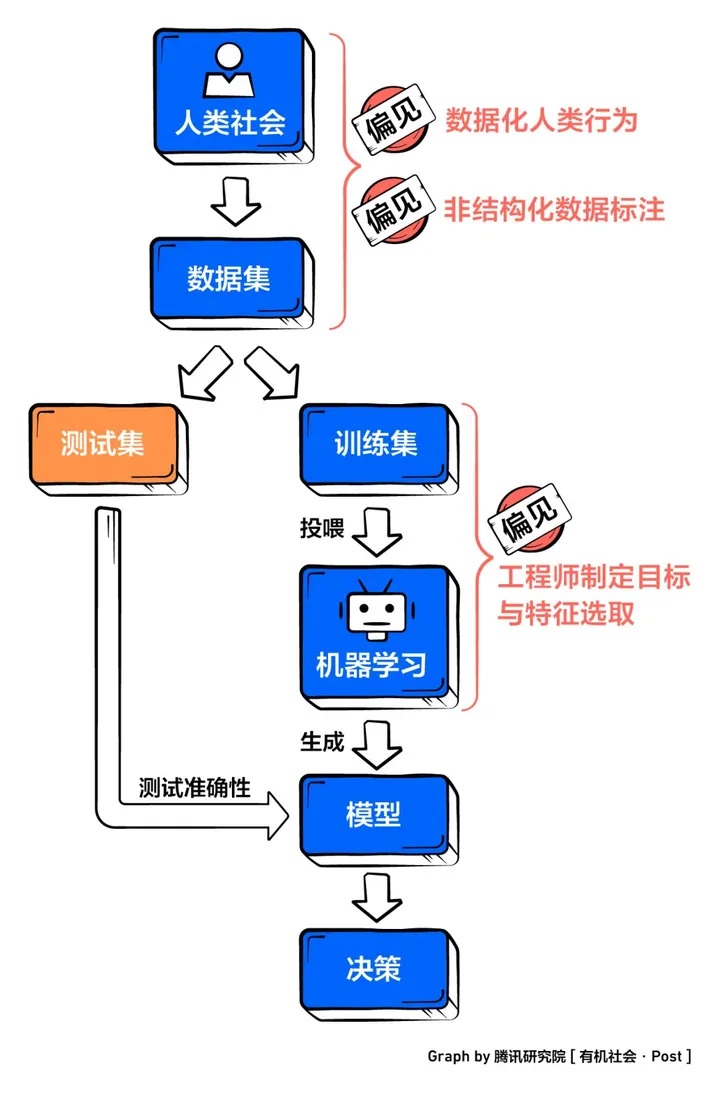

难道说,AI也会和人类一样,存在偏见或者倾向性吗?答案是肯定的。对于大语言模型而言,由于训练数据的影响会不可避免地存在性别偏见、种族刻板印象,等等。

我们知道,图像生成模型所采用的训练数据,会包含很多非结构化的数据集,比如各种图片,视频,描述性的文字等等。大量用于训练的图片,其对应的标签和描述都是人为主观生成的,当数据的标注者,给数据标注加上主观偏见后,特别是当这种偏见属于某个广大群体的主流时,大模型因此产生偏见也就不足为奇。

因此,小编认为,Meta的这个问题,折射出的实际上是欧美国家对于我们亚洲文明根深蒂固的偏见,对此,你们有什么看法?

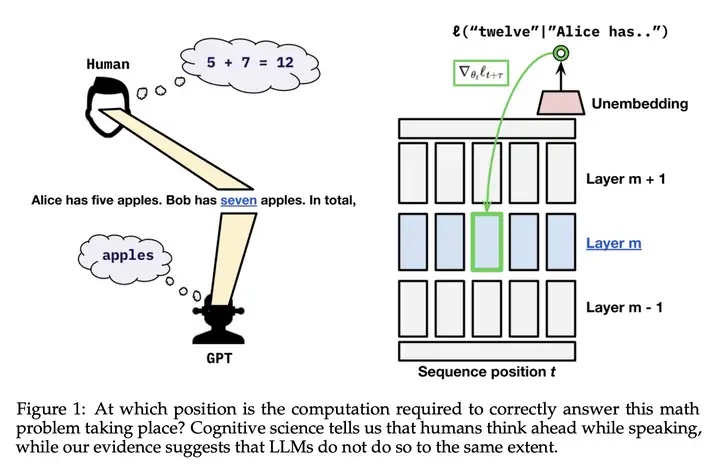

3. Transformer本可以深谋远虑,但就是不做

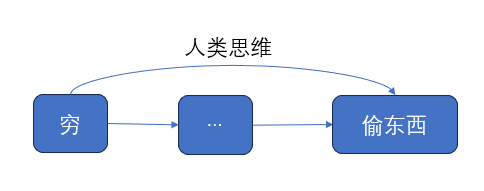

众所周知,人类在说话时会提前思考。比如说,当我以时,不管中间的故事内容是什么,我可能已经为某个结局埋下了伏笔,比如说“我因为偷东西被送进了警局”。

而同样众所周知的是,当代的大语言模型在“说话”时能够考虑到的token长度是有限制的,它生成一篇长文本需要经过多轮思考并依次生成token,每一轮能够分配给每个token的计算量是固定的。

如果我们让大语言模型以“我出生在一个穷苦的家庭”作为一个故事的开始,那么我们知道它同样有可能会以“我因为偷东西被送进了警局”。这是否表明,大语言模型能够像人类一样,在一开始就已经预测到了这个结局?还是说,大语言模型只是以“我出生在一个穷苦的家庭”为引讲述一个故事,随着故事一步一步的发展,最后恰好得到了这个结局?

让我们稍微抽象化一下这个例子:近期一些其他研究发现,可以通过探查语言模型的隐藏状态来预测下一token之后的更多 token。有趣的是,通过在模型隐藏状态上使用线性探针,可以在一定程度上预测模型在未来 token 上的输出,而干扰隐藏状态则可以对未来输出进行可预测的修改。

这些发现表明在给定时间步骤的模型激活至少在一定程度上可以预测未来输出,那么,这是否说明语言模型可以像人类一样,刻意地为未来的输出内容准备信息,亦或只是数据的偶然属性?

针对这个问题,来自科罗拉多大学博尔德分校和康奈尔大学的三位研究者发布了一篇题为《Do Language Models Plan for Future Tokens?》的论文。在论文中,他们得出的结论为:Transformer有能力通过牺牲当前位置的性能来为未来的输出准备信息,但是在实践中不会这样做。

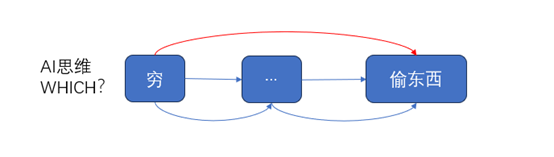

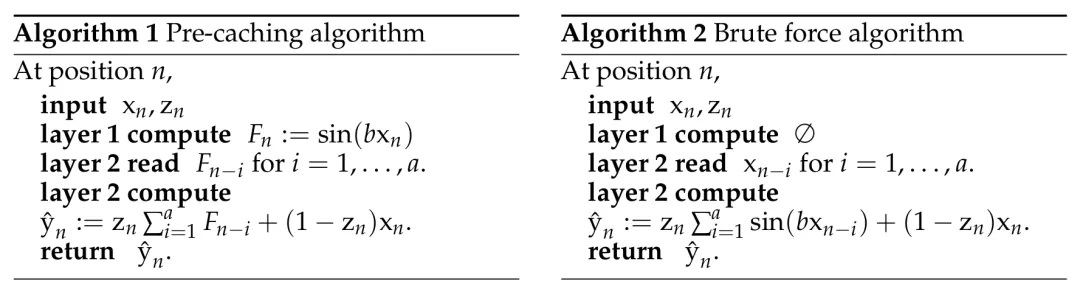

在文中,针对这个问题对应的语言模型的两种思维模式,研究人员提出了两种假说:

1. 预缓存(pre-caching):模型会有意识地计算对当前无用但是会对未来有用的特征。

2. 面包屑(breadcrumbs):模型只计算对当前最有用的特征,但是这些特征恰好对未来也有用。

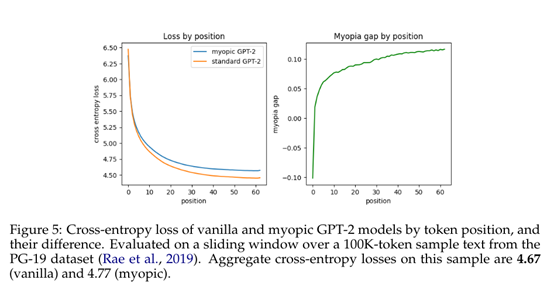

为了验证语言模型真实的工作场景是属于哪种假说,研究人员提出了一种“短视训练(myopic training)” 的方法。这种方法的核心在于,在训练语言模型的过程中,不将梯度传递到过去的隐藏状态,也就是移除反向传播。

在标准的Transformer模型训练中,模型的参数是通过最小化整个序列的累积损失来优化的。这意味着在训练过程中,模型不仅要考虑当前位置的预测损失,还要考虑未来位置的预测损失,而这些损失通过反向传播相互关联。因此短视训练可以很好地量化模型在多大程度上进行了预缓存。

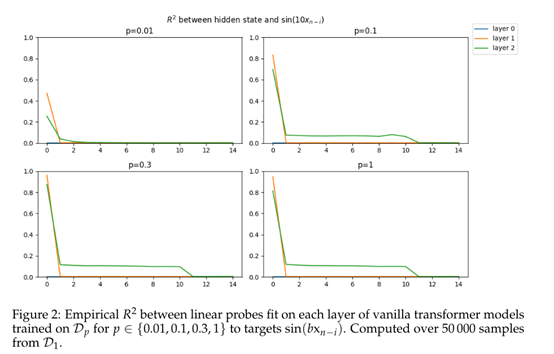

研究者们设计了一种合成场景,在其中只能通过显式的预缓存完成任务。他们配置了一种任务,其中模型必须为下一 token 预先计算信息,否则就无法在一次单向通过中准确计算出正确答案。

在这个合成场景中,该团队先是不使用短视训练的方法,发现了明显的证据可以说明 transformer 可以学习预缓存。当基于 transformer 的序列模型必须预计算信息来最小化损失时,它们就会这样做。而当研究人员采用短视训练后,最终模型性能大幅下降。

然而,在语言建模的实验中,移除过去时刻的反向传播仅仅导致性能小幅下降,但是没有完全移除过去上下文影响那么大,这更支持“面包屑”而不是有意识预缓存的假说。

最终研究人员表示:「在语言数据中,我们观察到贪婪地针对下一 token 损失进行优化与确保未来预测性能之间并不存在显著的权衡。」

实际上,根据实验内容我们可以看出来,Transformer并不会主动在预缓存和面包屑中进行抉择,所有的结果都是由模型训练的数据决定的。当训练数据要求模型必须有预缓存的能力时,最终的模型也自然会“想得更远”。

那么,这是否意味着,作为当代大语言模型的训练数据,也就是当代人的言论和文章,本来就没有太多“深谋远虑”的成分呢?欢迎大家提出自己的想法。

1. https://mp.weixin.qq.com/s/OGjA_2HMvpHjKs1RxWWIpw

2. https://www.thepaper.cn/newsDetail_forward_26757872

3. https://mp.weixin.qq.com/s/eUhOxh5qlGQHOGqgPgFqPQ

4. https://www.zhihu.com/question/347755861

5. https://mp.weixin.qq.com/s/?__biz=MzA3MzI4MjgzMw==&idx=2&sn=b762b8bdbbae4ab828337409f8de6846

6. https://zhuanlan.zhihu.com/p/691199339