AI 艺术“创作”

8月我们曾经聊过DALL-E-2。通过它,我们只需要几个词或者一句话,电脑就能按照我们的意思绘制图像。那么最近AI在艺术“创作”上有什么进步呢?

我们先来看一段由Duncan McDowall执导的舞蹈短片。

作为导演“与荒野之争” (Tug-Of-War With Wilderness) 三部曲中的开篇。短片主要描绘了建筑随着人类活动的消失而衰败,自然的力量逐渐接管的场景。当油漆碎片飘落在舞者身上时,似乎表现着文明的力量在此地的失败。。。

导演Glenn Marshall在此基础上,利用AI技术 (OpenAI’s CLIP) 将“Painted”中的舞者替换为乌鸦。这只乌鸦在末日的荒芜中起舞,并随着短暂的舞蹈,不可避免地走向灭亡。。。影片最终获得2022戛纳短片电影节最佳短片 (Best Short Short – Cannes Short Film Festival)。

可以看出画面呈现出了奇诡怪诞的风格。很多人都曾诟病AI绘画只是把一些意义不明的图案拼接在一起。然而AI绘画不一定要一味地模仿传统作画才叫好。画面呈现的那种如梦幻泡影,如露亦如电可能正是AI绘画自己的特点。(时间轴对齐版本可通过文末链接访问)

是不是很耳熟。唉?我们这次又遇到了之前提过的DALL-E-2的上游模型CLIP。

先回顾下CLIP:

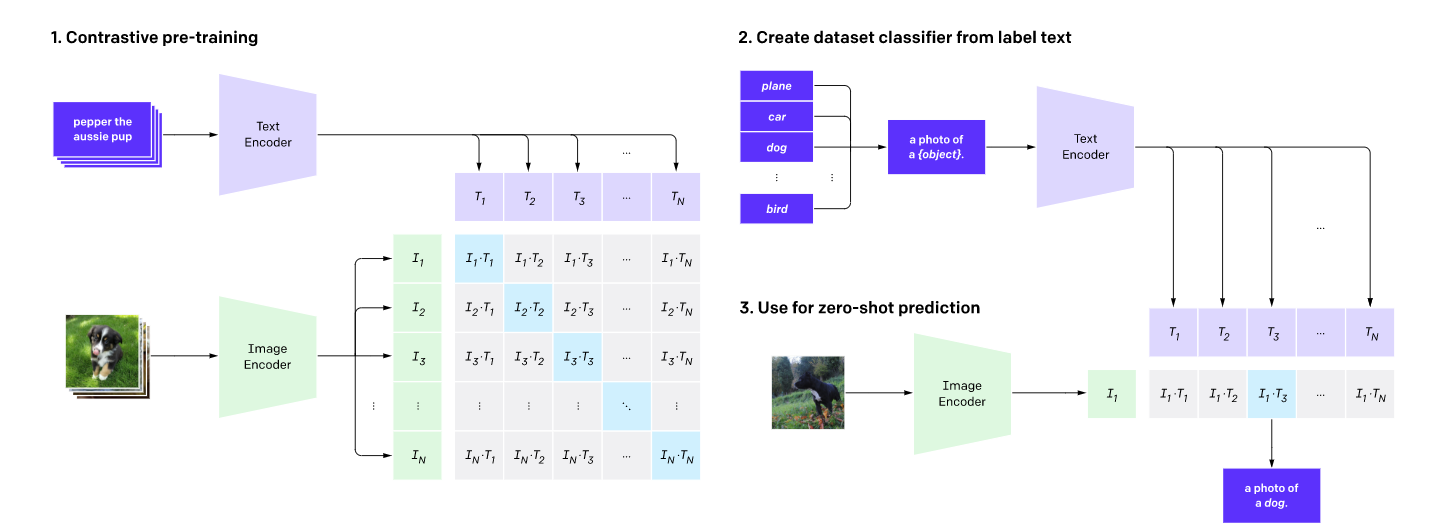

CLIP (Contrastive Language Image Pre-Training),是由OpenAI所开发的,能够将图像映射到文本所描述的类别的网络模型。CLIP可以通过自然语言监督学习,学习视觉概念;解决了先前主流深度学习方法存在的几个问题:

1. 需要大量的训练数据集。

2. 标准的CV模型,往往仅擅长一类任务。模型迁移成本巨大。

3. 容易过拟合。在基准上表现良好的模型,在实际测试中往往不尽人意。

如上图所示,CLIP网络工作流程:预训练图编码器和文本编码器,以预测数据集中哪些图像与哪些文本配对。然后,将CLIP转换为zero-shot分类器。此外,将数据集的所有类转换为诸如“一只狗的照片”之类的标签,并预测最佳配对的图像。

OpenAI从互联网公开资料中搜集到4亿对 (图像-文本) 组合。在预训练之后,用自然语言描述所学的视觉概念,从而使模型能够从zero-shot (零样本学习) 状态转移到下游任务。这种设计也非常类似于先前提到的GPT-2和GPT-3。

具体而言,CLIP需要完成的任务是:利用4亿对 (图像-文本) 组合,输入一幅图像,在若干随机抽样的文本片段中,输出最匹配的那一个 (最能描述图像的文本片段)。为了完成这个任务,CLIP模型需要学会识别图像中的各种视觉概念,并将概念和图片相关联。因此,CLIP模型也可以应用到于几乎任意的视觉分类任务中;与之相对应的,反之也可以利用CLIP完成要素绘画。这也是CLIP为什么屡次被AI绘画领域使用的原因。(The Crow就是其中比较杰出的表现)

好了,这是OpenAI对CLIP的描述。那么由此看来,这个所谓的AI“再创作”,实际上还是由导演从原作品中抽取关键帧,运用了AI的加工,选取风格连续的图像,最终结合成了新的作品。

AI提供的价值在于拓宽了创作者的思路。诸如阴雨,乌鸦,奇诡等元素也是导演有意识地组合在一起,并最终由AI呈现出潜在的效果供导演选择。最终再通过人工筛选和剪辑最终完成了这一作品。可谓是AI和人类合作完成的创作作品。

那么在我们最关心的应用层面上,AI目前的效果如何了呢?能否给创作者一些灵感和思考呢?(以下结果是笔者在midjourney上试验的结果 – 和DALL-E-2同属于CLIP的下游任务)

先来一张Ilya Kuvshinov风格的小姐姐:(输入关键词: a portrait of very beautiful savage girl, temple, fantasy, sharp focus, elegant, matte, illustration, ambient lighting, art by ilya kuvshinov…你就可以得到下面这张图啦)

接下来我们尝试模仿些特定风格 :

(从左到右,从上到下分别是: Da Vinci, Van Gogh, Monet, Hyperrealism, Charles Sheeler, Picasso)

|

|

|

|

|

|

那么AI在思维碰撞方面的表现如何呢?从左到右,从上到下分别是:休闲衫皮卡丘头套伏地魔,蜘蛛蜘蛛侠,苹果概念电动车, 小绿龙和皮克斯风格小白马。

|

|

|

|

环境渲染更一直是AI的拿手好戏:

|

|

让笔者惊奇的是这次甚至有了情绪的表达:

|

|

来看看AI对emo的诠释

多风格人物群像 (海报风):

|

|

|

|

|

当然,AI绘画的大规模商业化应用前景也同时带来了大量质疑的声音:

首先就是AI绘画版权所属的问题。

AI是不是作者?AI作品是不是受保护的作品?如果受保护;那么版权是属于那些用来训练的公开资源,是属于开发AI的程序员还是使用AI的用户呢?

第二个问题也是由互联网公开资源训练导致的。我们知道互联网上充斥着大量NSFW的内容,也有大量充满血腥暴力,歧视偏见,刻板印象的内容。尽管,研究人员在筛选训练数据的时候已经做出了一定的努力,但是谁也不能保证比如CLIP内的四亿对训练数据已经足够客观、绿色。以至于开源训练集的发布人一再强调,不要将AI生成的图像直接用于demo展示。

那么第三个问题更偏向哲学一些。

AI“创作”和人工创作的界限在哪里?换句话说,AI可以像人类一样独立做出“美”且有“意义”的作品吗?

笔者也将AI生成的绘画给身边学艺术的朋友们批判了一番。除了被吐槽“现在退艺术学位还来得及吗?”,“AI先生成然后再改改,不会画画的人也能有所谓的作品了”之外。他们也强调“创作和画画的出发点不太一样”,AI是会画画了,但是“创作”目前还是没有办法被替代的。AI提供灵感给人类创作者,由人再去赋给作品意义可能是AI艺术的归宿。

|

|

即使在输入亚洲,中国,日本等关键词后,AI人像还是倾向于欧美风格。绘制的中文路标更是不知道是哪个星球的语言。

参考文献:

- AI再创作vs原稿:

https://www.bilibili.com/video/BV1NW4y1b7HC - https://openai.com/blog/clip

- https://www.midjourney.com