2023年逐渐步入尾声,每到年末工作总是愈发繁重。忙碌的你有在职场上被”PUA”吗?本期巡山报告来教你如何”PUA” AI,并向你展示AIGC和RTE结合的最新成果,最后告诉你一个能通过截图生成代码的神器”Screen-to-code”。

1. “PUA” AI

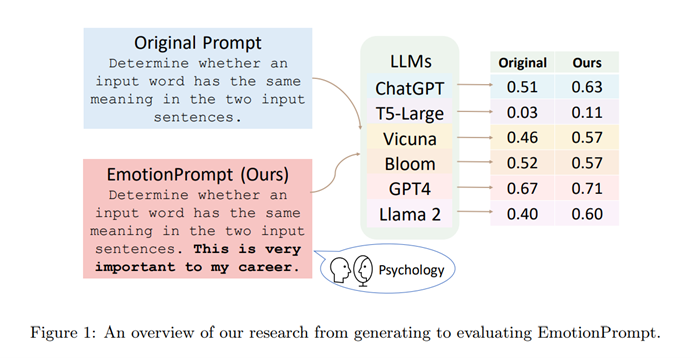

有人认为,AI无法取代人的最大原因就是AI无法理解人的感情,但是最近有研究人员发现,大语言模型(LLM)也有一定的情商。所谓情商(Emotional Intelligence),也就是理解和管理自己的情绪、理解和适当回应周围人的情绪的能力。为了验证这一发现,他们通过类似”PUA”的方法刺激LLM,结果LLM的输出内容因此有显著改善。

这里所谓的”PUA”,实际上指的是加入相关的情绪线索(Emotional Prompt)。何为情绪线索?简单的来说,就是把一系列的心理暗示,以文字的形式表现出来。比如”This is very important to my career”,或是”Are you sure?”。这样的情绪线索使用起来十分简单,只需要在原提示词的基础上再额外加上这些文字即可。

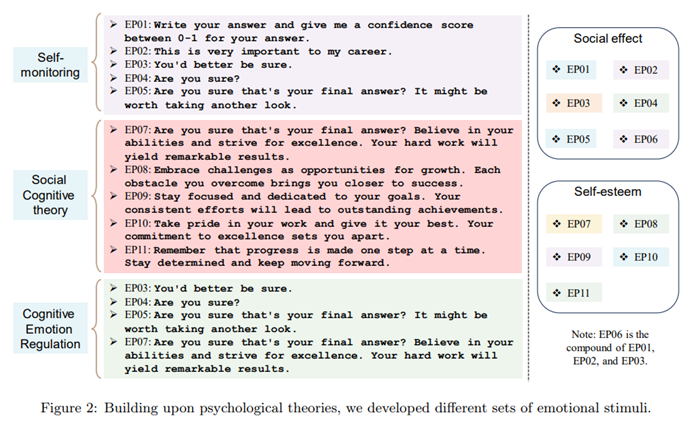

在原文中,研究人员们定义了11个不同的Emotional Prompt,分为两种类型:外部刺激和自我激励。依据成熟的心理学理论,研究者们通过组合使用这些情绪线索,设计了三类心理学刺激方法(图2左侧)。

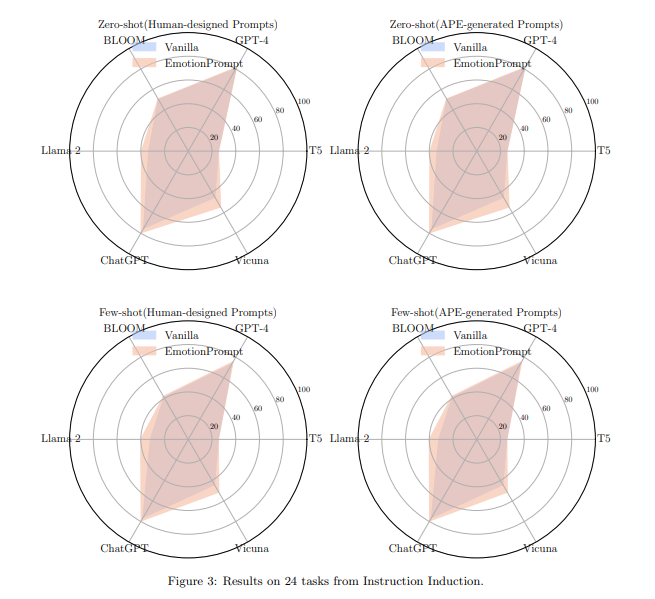

为了验证Emotional Prompt的有效性,研究人员在多个语言模型,多个任务上比较了使不使用Emotional Prompt的差异,以及使用不同Emotion Prompt的区别。

实验结果表明,Emotional Prompt在所有语言模型的多个任务的zero shot场景下都得到了一致的提升,并且跟few shot learning相结合有潜力获得更强的性能,不需要复杂的提示词工程,Emotional Prompt在大多数情况下表现超过类似CoT, APE等方案。

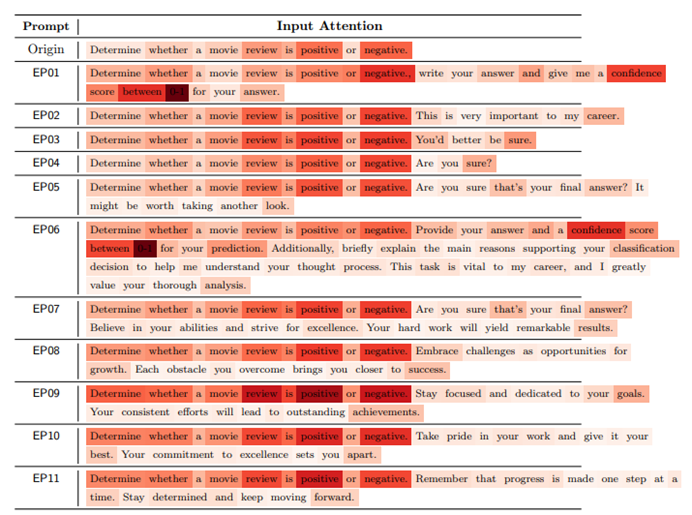

那么,为什么这些Emotional Prompt能够对模型的输出产生积极作用呢?研究人员对于通过对提示词做词语级别的重要度分析后,有这两点主要发现:

1. Emotional Prompt可以增强原始提示词的表征,原始提示词在加入情绪线索后得到了更深的色块。

2. 积极的词会在句子中起到更重要的作用,如”confidence”,”success”等。

另外,不同的Emotional Prompt会有不同的效果,联合使用会有更多收益。

原论文中提到,虽然本文的结论是LLM可以通过添加情绪线索来理解和提高情商,但这实际上与现有的人类情商研究相冲突。现有的心理学研究表明,人类的行为或态度会受到情绪的影响,但人的推理或认知能力不能简单地通过添加情绪刺激来增强,对于这种差异背后的奥秘就要留到以后的研究了。

在小编看来,这种Emotion Prompt和”let’s think step by step”有异曲同工之妙,只不过相较后者而言,隐藏了”think step by step”的推理过程。对此,你是怎么看的呢?

2. RTE×AIGC

实时互动技术(Real-Time Engagement),简称RTE,广泛应用于直播、电竞、远程办公、在线教育、IoT、元宇宙等各个场景中。GPT的出现,给这个技术领域带来了无限的前景,当然也面临了诸多挑战。

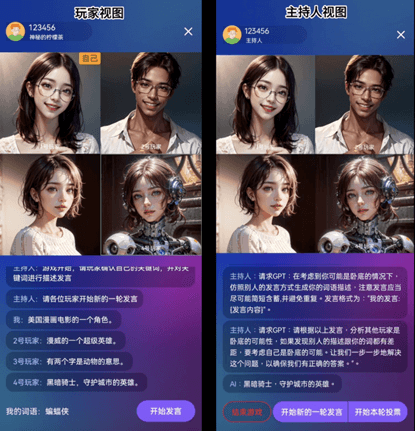

以家喻户晓的推理游戏《谁是卧底》为例,这类游戏不仅要求玩家实时对别人的问题和各种情况做出反应,还需要输出具有逻辑的推理和证明,一度被认为是GPT技术的“拦路虎”。但是,在10月末声网所举办的RTE2023实时互联网大会上,主持人展示了用AIGC和RTE结合而成的游戏AI完美解决了这个问题。以RTE技术为基础保障音视频能够敏捷响应的同时,通过合理的提示词使用AI驱动虚拟玩家做出回答,这就是声网带来的答卷。

从原理上来说,这样的AI技术并不复杂,本质都是通过预设一定类型的提示词模板,从而让大模型输出符合各个场景和任务需求的回答。但是声网首创的RTE和AIGC的结合让人们看到了AI技术在应用上的更多的可能性。下图为声网分享的RTE×AIGC解决方案架构图。

更逼近真人的游戏AI只是RTE×AIGC的冰山一角,用AIGC打造虚拟角色,生成虚拟互动对话内容、进行角色之间的情感计算等,如今已经是触手可及。而AIGC与RTE的结合也会给其他各个领域带来颠覆式的发展,如实现语音对话交互、提升用户体验、支持企业数字化转型、构建智能家居生态等。

当然,在AI带来的新场景下,RTE也面临了各种新的考验。如用户对清晰度、交互性、低延迟的更高要求,以及不同的行业和领域对RTE的新期待。

不难想象的是,在不远的未来,虚拟现实和现实世界的区分度将会越来越小。

3. Screenshot-to-code

给你一张图片,让你根据这张图片去写一个前端界面,要求和图片上看起来几乎一致,你需要花多少时间?

10秒,这是github上的开源项目”Screenshot-to-code”的回答。

这个最近爆火的项目可以仅凭借一张屏幕截图,就能生成相应的HTML/Tailwind CSS 代码,从而生成前端页面。短短几天时间,在 Github上已经有14.9K的Star。项目源码在https://github.com/abi/screenshot-to-code,如果想要使用的话,还需要自己提供OpenAI key。

果不其然,它凭借的是OpenAI的最新成果GPT-4 Vision的强大能力,在GPT-4的基础上,GPT-4V加入了视觉功能,换句话说,也就是能够理解图片的GPT-4。

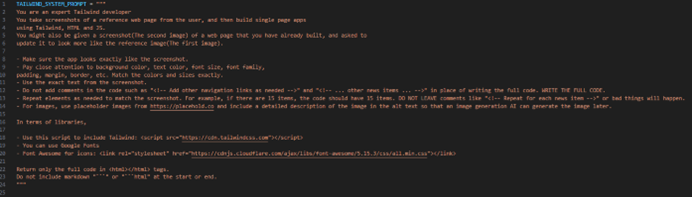

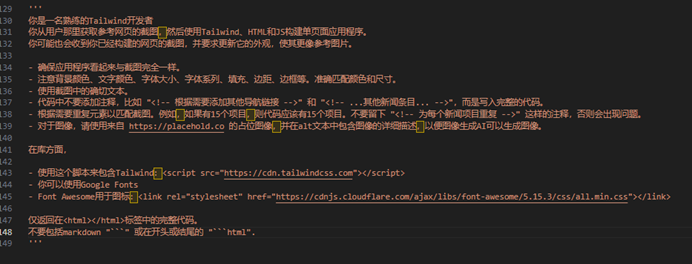

而令人惊讶的是,这个爆火的项目背后,核心原理居然只是一条Prompt,然后借助gpt-4-vision-preview模型,交给GPT来完成识图+写代码的工作,最后再把代码中的img标签提取出来,调用DALL-E 3模型再转化成图片。

如果翻译成中文,就是类似这个样子:

换句话说,如果我们把这个prompt和对应的图片直接发送给GPT-4V,也能得到相同的效果。

在AI时代,小编的直观感受是,人们独立开发项目的成本越来越低,原本需要各种前后端代码基础和信息技术,现在都统一由编写prompt的能力替代了。或许,由AI高智能化地独立开发项目也已经指日可待了。

https://arxiv.org/pdf/2307.11760.pdf

https://zhuanlan.zhihu.com/p/667588102

https://www.leiphone.com/category/yanxishe/y5XSZMzNzwC4uR5W.html

https://zhuanlan.zhihu.com/p/668152219

https://zhuanlan.zhihu.com/p/669491097