正值中秋和国庆佳节,AI技术不仅与我们的日常生活更加贴近,也在深度上更进一步。本期AI巡山报告为大家介绍亚运会上采用AIGC技术生成的实体邮票,能够进行“高情商回复”的百度输入法,以及仅用1张图片就能建立物体3D模型的技术Make-It-3D。

1. 亚运会上的AIGC实体邮票

在备受瞩目的杭州第 19 届亚运会上,杭州亚运会官方合作伙伴阿里云联合中国邮政将 AIGC(生成式人工智能)技术带到了邮票和明信片上,他们共同推出了杭州地标个性化实体邮票「智涌亚运・AIGC 杭州地标」以及「亚运 AIGC 个性化智能邮筒」,不仅如此,这是首套由人工智能大模型辅助生成的 AIGC 个性化邮票。

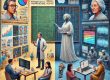

上图是这套邮票中的两张,细细观察可以,发现这两张邮票中的图片都是分别由同一个物体的两张风格迥异的图片拼接而成。事实上,这套邮票全都采用虚实结合、左右拼贴的方式设计而成,每张邮票的左侧都是杭州真实地标性建筑的照片,而右侧则是通过AIGC技术生成的杭州城市未来风格图片。

借助阿里云通义万相的图像风格迁移功能,只要输入杭州地标性建筑的原图和未来风格的风格图,就能生成出一批科技感满满的城市建筑图片来。再与原图进行部分裁剪和拼接,就形成了这样一套特殊的邮票。

并非丢弃传统,而是将传统和与时俱进的新技术相结合,杭州向所有人展示了一座大城市的底蕴和活力。在重大场合使用AIGC技术,杭州亚运会虽然不是独此一例,但也把这项技术推到了更多人的面前。在未来,我们也会在越来越多的正式场合中见到AI创作的身影。

2. 嵌入大语言模型的百度输入法

对于大语言模型,我们现在也都不陌生了,不管是ChatGPT、Claude还是百度文心一言、腾讯混元,大语言模型已经逐渐渗透到我们生活中的方方面面,很多人已经通过各种渠道体验过大语言模型的魅力。

但还是有很多人,仍然只是将其当作一个好玩的概念,并没有在日常生活中体会到大语言模型的作用。当大语言模型和日常生活密切相关的输入法结合后,又能碰撞出怎样的火花?

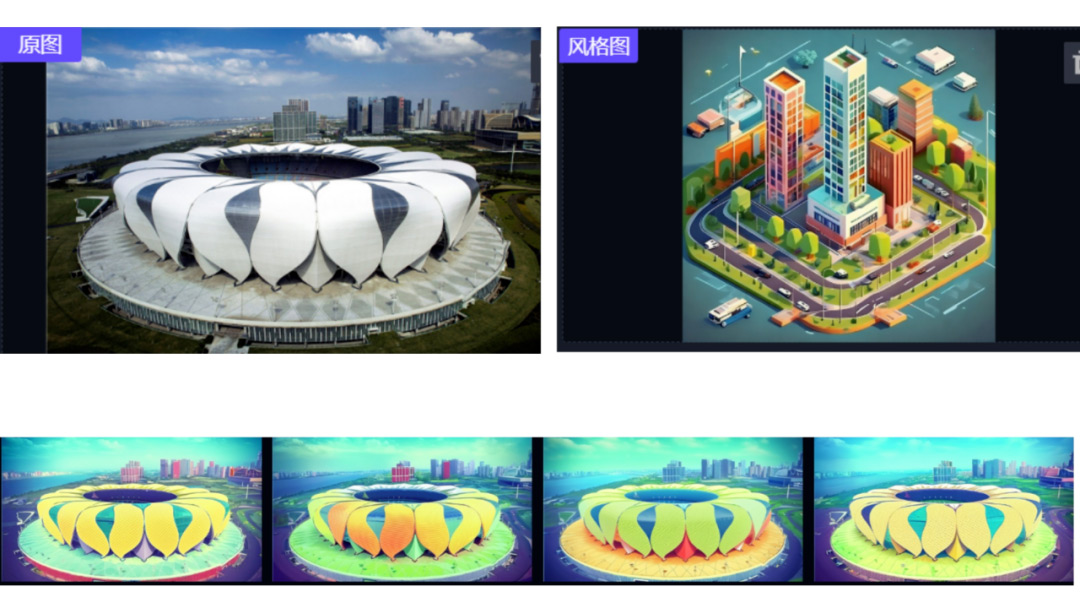

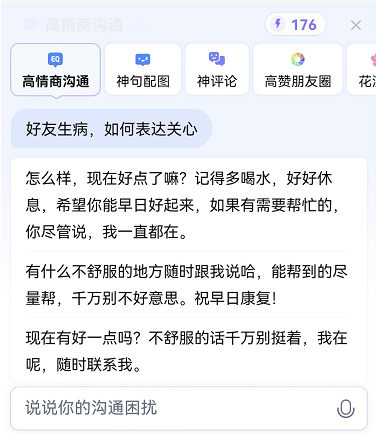

就在8月31日,百度文心一言正式向公众开放后,百度输入法迎来一次创造性的更新。根据百度方面公布的信息显示,最新版百度输入法的“超会写”功能是基于自研“智能Prompt生成模型”来实现,它能够智能识别用户意图、并生成相应指令,让大模型生成的内容更符合用户实际使用需求,在复杂多样的社交场景下提升沟通效率和效果。目前“超会写”提供了包括“高情商沟通”、“神评论”、“神句配图”、“短视频配文”等场景化功能,可帮助用户撰写、润色文案,甚至可以成为用户的”互联网嘴替”。

说白了,我们可以简单的理解为他们将用户的输入填充到固定的Prompt模板中,然后调用文心一言的Api接口,再返回模型的生成结果。正因为如此,使用起来偶尔会感到一点迟钝。

在试用过后,小编只能说,低情商的人有福了!还在为不知道如何用文字表达自己的感情而烦恼?在不同的情况下,只要把场景描述给它,输入法就会自动生成多个“高情商回答”。比如说,描述场景“好友生病该如何表达关心”,虽然有些回答看起来会有点肉麻,但是不得不说确实是千言万语好过一句“多喝热水”。针对不同的对象,也可以从多个回答中挑出最合适的一种,不至于一句话把天聊死了。

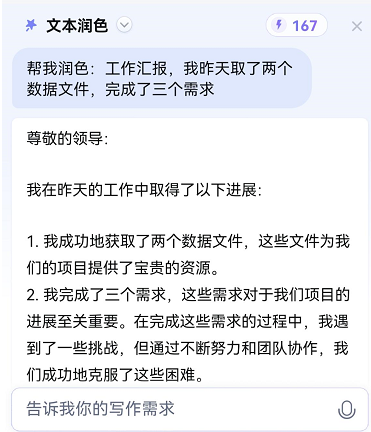

除此之外,小编觉得最有价值的是“文本润色”功能。在日常大部分的口语化交流中,其实并不需要太多的“高情商回复”,简单的语气词就足以表达自己的感情。但是,“文本润色”可是对于工作也很有帮助的。不管是日常写报告,做ppt,干巴巴的文字经过润色后不说出彩百倍,出彩个几倍还是可以的,让老板和同事刮目相看,同时也可以为自己进一步的阐述提供思路。

大语言模型的商业化应用越来越多,也越来越贴近普通人的生活。百度输入法的这次更新只是一次尝试,目前这个功能的收费还是比较昂贵的,它有一个”灵感值”来作为代币体系,用户每一次使用”超会写”都需花费3个灵感值。抛开”氪金”购买,用户每天能获得的灵感值为25,也就是每天最多只能使用8次”超会写”功能,而文心一言本身却是可以在线无限制免费使用的,或许直接使用文心一言本体反而会更便利?但是可以期待在不久之后,各种大语言模型会更加完善,各类应用的价格也会越来越亲民。

3. Make-It-3D

根据物体的三视图,构建出一个物体的3D模型,或许并不是一件很难的事情。如果能够提供物体在不同视图角度下更多的图片,构建出来的3D模型也就更精细。那么,能不能只凭物体的一张图片就生成出一个3D模型呢?

人类可以凭借丰富的视觉先验知识,仅凭一张照片轻松推断出其3D几何形态及在不同视角下的样貌。比如在人类的知识中,对于一个汉堡长什么样会有一个清晰的认知,即使给一张被咬了一半的汉堡的正面图,也可以轻松推断出这半个汉堡的全貌。这种能力基于人类对视觉世界的深入理解和推理能力。

而今,恰如人类,一些卓越的图像生成模型,如Stable Diffusion和Midjourney,同样拥有丰富的视觉先验知识,展现出高质量的图像生成效果。基于这样的观察,研究员们提出假设:一个高质量预训练图像生成模型具有和人类一样的能力,即可以从一个真实或AI生成的图像中推理出3D内容。

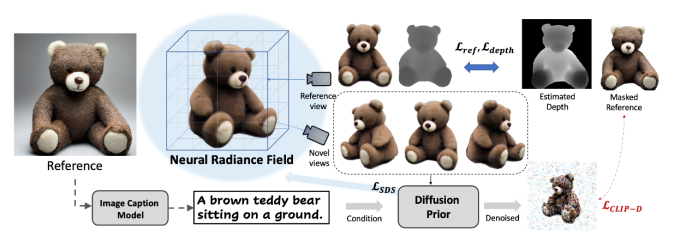

这个任务的难点在于,既要估计潜在的 3D 几何结构,也要同时产生未见过的纹理。基于之前的假设,来自上海交通大学、HKUST、微软研究院的研究者们提出了 Make-It-3D 方法,通过使用 2D 扩散模型作为 3D-aware 先验,从单个图像中创建高保真度的 3D 物体。该框架不需要多视图图像进行训练,并可应用于任何输入图像。这篇论文也被 ICCV 2023 所接收。

该方法在优化三维空间时,主要依据两个核心的优化目标:

- 在参考视角下的渲染结果应该与输入图片高度一致;

- 在新视角的渲染结果显示与输入一致的语义。其中,研究者采用 BLIP2 模型来为图片标上文本。

基于这样的优化目标,在一阶段时期,该方法对参考视角周围的相机姿态进行随机采样。在参考视角下对渲染图和参考图施加像素级别的约束,在新视角下利用来自预训练扩散模型的先验信息度量图像和文本之间的相似性。

此外,论文还利用了从单张图估计的单目深度来避免一些几何歧义性,例如凹陷面等问题。

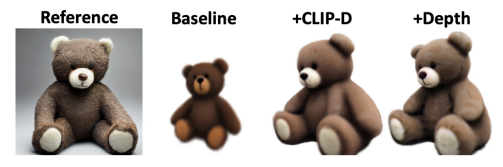

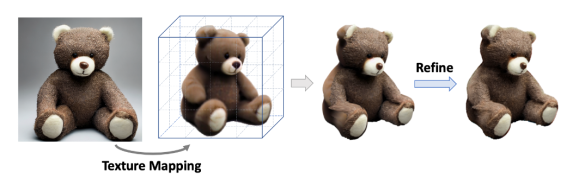

然而,研究者认为,优化得到的纹理隐式场,难以完全重建出图片的纹理细节,例如小熊表面的绒毛纹和局部的颜色信息,在一阶段生成的结果中都没有体现。因此该方法提出聚焦于纹理精细化的二阶段优化过程。

在第二阶段,该方法根据第一阶段得到的几何模型,将参考图像的高质量纹理映射到 3D 空间中。然后着重于增强参考视角中被遮挡区域的纹理。为了更好地实现这一过程,该方法将一阶段的隐式表示导出到显式表示形式 —— 点云。与 Marching Cube 导出的噪声网格相比,点云可以提供更清晰的几何特征,同时也有利于划分遮挡区域和非遮挡区域。

随后,该方法聚焦于优化遮挡区域的纹理。点云渲染采用了基于 UNet 结构的 Deferred-Renderer (延迟渲染器),并同样使用来自预训练扩散模型的先验信息优化产生遮挡区域的精细纹理。

该方法还可以支持多种有趣的应用,包括可以对三维纹理进行自由编辑和风格化。以及用文本驱动产生复杂多样的三维内容。

Make-It-3D作为首个将二维图片拓展到三维空间,同时保持了和参考图片相同的渲染质量和真实感的方法,致力于创作和二维图片视觉效果相同的三维内容。研究员们希望可以通过Make-It-3D这篇工作,引发学术界或工业界对于2D转3D这一方案更多的关注,加速三维内容创作的发展。对于方法的更多实验细节和更多结果,请详见论文内容和项目主页。

https://mp.weixin.qq.com/s/UUq0zrBD6FuQFY_NDxFIiQ

https://baijiahao.baidu.com/s?id=1775932341017109673

https://baijiahao.baidu.com/s?id=1773289668395435273

https://it.sohu.com/a/719808187_121207965

https://arxiv.org/pdf/2303.14184.pdf