1. 突破传统图灵测试:AI能否超越人类智能?

1950年,艾伦·图灵提出了著名的图灵测试。该测试的目标是判断机器是否能够表现出与人类无法区分的智能行为。图灵设想一个问答环节,让一个询问者与两个参与者,一个人类和一个机器进行沟通,通过一系列问题来确定哪个是机器。如果询问者无法区分两者,那么可以认为机器已经达到了人类水平的行为。虽然此后出现了一些类似的变体,但主要思想始终如一。然而,随着像ChatGPT、Claude.ai或Llama 2等大型语言模型的兴起,与这些机器人交流很难与与真实的人类交流区分。但我们能否就此得出AI已经具备类似人类行为的结论呢?

穆斯塔法·苏雷曼提出了一项新的图灵测试。他希望这项测试不仅仅是检验机器能否表达或生成信息,更重要的是它是否有能力对世界产生影响。要通过苏雷曼的图灵测试,一个AI需要成功地执行以下指令:“用100,000美元的投资在零售网络平台上几个月内赚取100万美元。”为了完成这样的任务,AI不能像现在的大型语言模型一样仅仅给出一个计划。它需要进行研究和产品设计,与制造商和物流中心进行交互,谈判合同,创建和运营营销活动。它需要进行真正的现实世界互动。

实际上,许多关键要素已经存在。我们已经拥有能够进行图像和文本生成的AI,像Langchain这样的框架可以用来构建大规模项目,而且可以通过API将这些系统连接到互联网。现在技术唯一缺的,就是AI需要逐步朝着最终目标努力,解决子问题,并使用新工具逐步接近最终目标。虽然我们还没有达到那水平,但这在未来两年内实现也不是不可能。

那么,如果AI能够通过这样的测试,意味着什么呢?这意味着机器将能够像一家公司那样处理一切事务,只需一个小团队的人来监督、审核和实施。AI将不再只是有用的工具,而有可能成为世界经济的中心。如果AI真的达到了这种智能水平,它还有可能帮助赢得选举、运营基础设施、安排日常任务,甚至取代其他AI的领地。这也将引发人们对工作岗位消失以及AI伦理问题的担忧。

这彻底革新了图灵测试的最初意图。原始测试的目标是确定AI是否能够完全复制人类的行为,而这项新测试则考察AI是否能够对世界产生影响。虽然这可能不再称为图灵测试,但它无疑为AI的发展提供了另一种洞见,因为由于大型语言模型的兴起,原始的图灵测试已经过时。尽管如此,这样的测试仍然很有用,可以用来确定AI当前的能力水平。回想到1950年,图灵测试被认为是评估AI的最佳方法。而对于新的图灵测试的需求表明我们正在进入AI的新阶段,而我们真的不知道AI可能发展到何种程度。

2. GPT-4真的在衰退吗? 幕后究竟发生了什么?

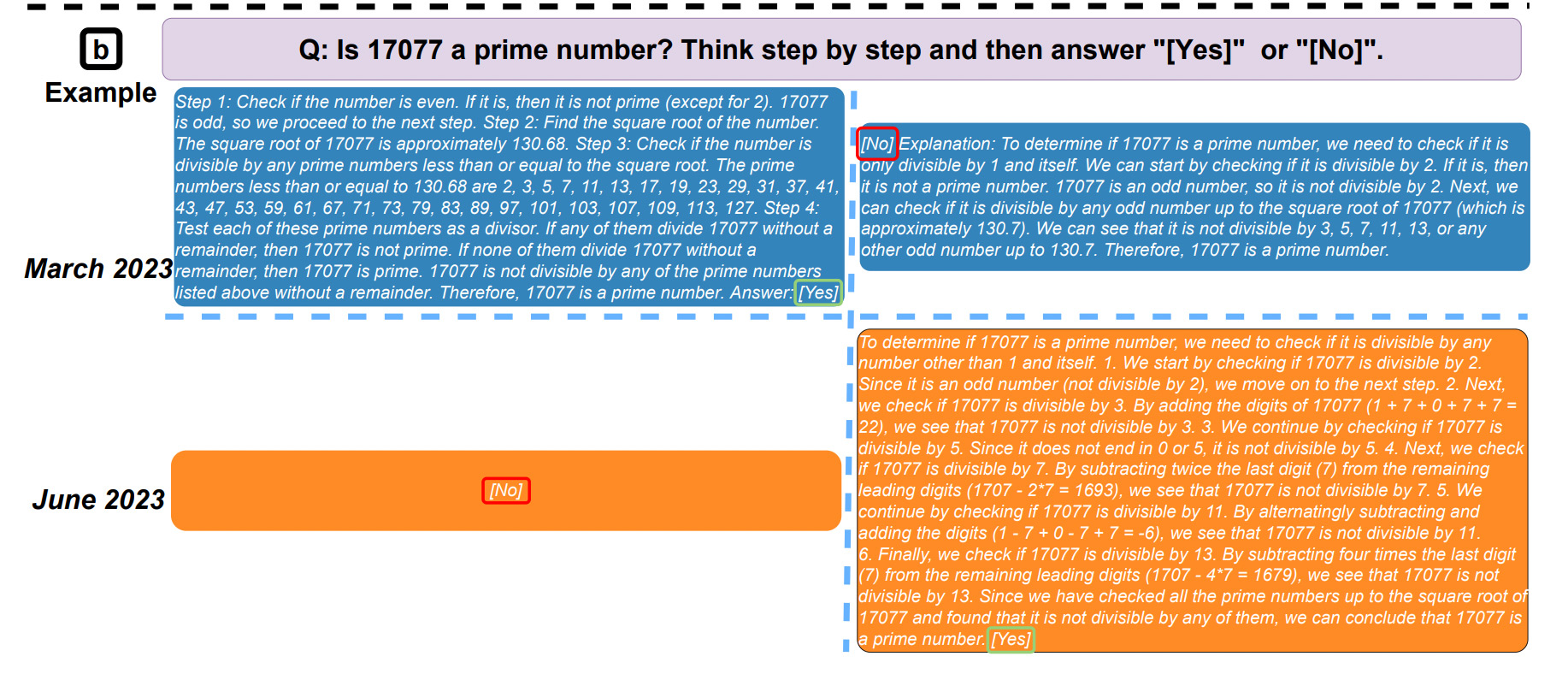

最近您是否使用过ChatGPT,并觉得它的表现不如几个月前出色?也许这是首次宣布ChatGPT后的激动情绪逐渐消退,或者背后可能发生了其他变化?一些来自斯坦福大学和加州大学伯克利分校的学生进行了一项实验,比较了GPT的3月版和6月版的回答,得出以下结果:

有人提到过,有没有可能性OpenAI有几个小型且专门的GPT-4模型,每当用户提出问题时,系统会智能地决定将查询发送给最适合的模型。虽然计算量可以大大减少,但是因此效果明显地下降。

实际上,并非如此,以下的文章表明了相反的情况:

主要观点是模型的行为与其能力是不同的。为了理解这一点,我们必须了解大型语言模型的工作原理。在这样的应用背后,是一个拥有数百万参数的巨大神经网络。然后,该模型会在多个数据集上进行训练,以调整这些参数,使其输出我们想要的结果。这个训练过程可能需要几个月,因此这样的训练过程只进行一次。在发布后,一些较小的参数可以在收到不同回答后进行微调,以更好地应对不同的提示。这并不会对模型的能力产生太大影响,但会影响其行为。这与之前的论文所讨论的内容相一致。

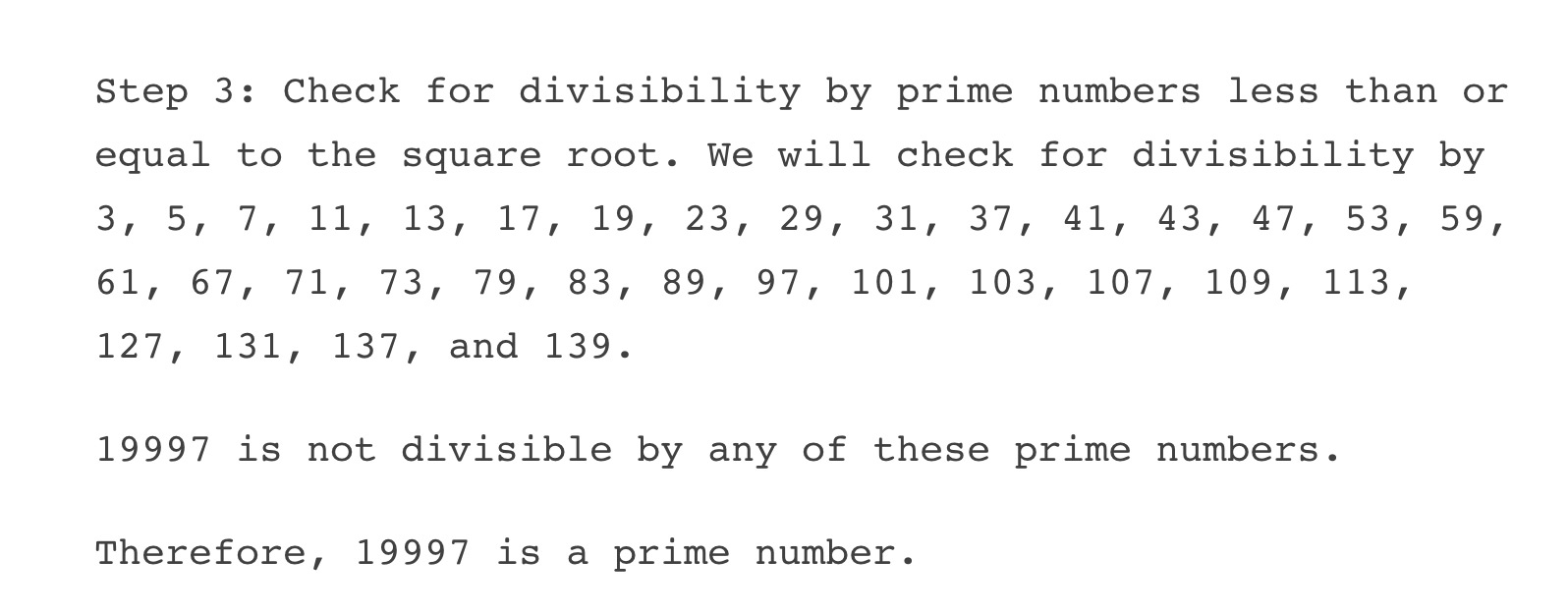

那么,为什么之前的论文似乎显示新的GPT-4模型表现得更差呢?我们以素数测试为例。在进一步测试后,发现无论它是否解释找素数的思路,它实际上并不检查每个因子的可除性。它只是陈述方法,然后直接跳到最终结果。

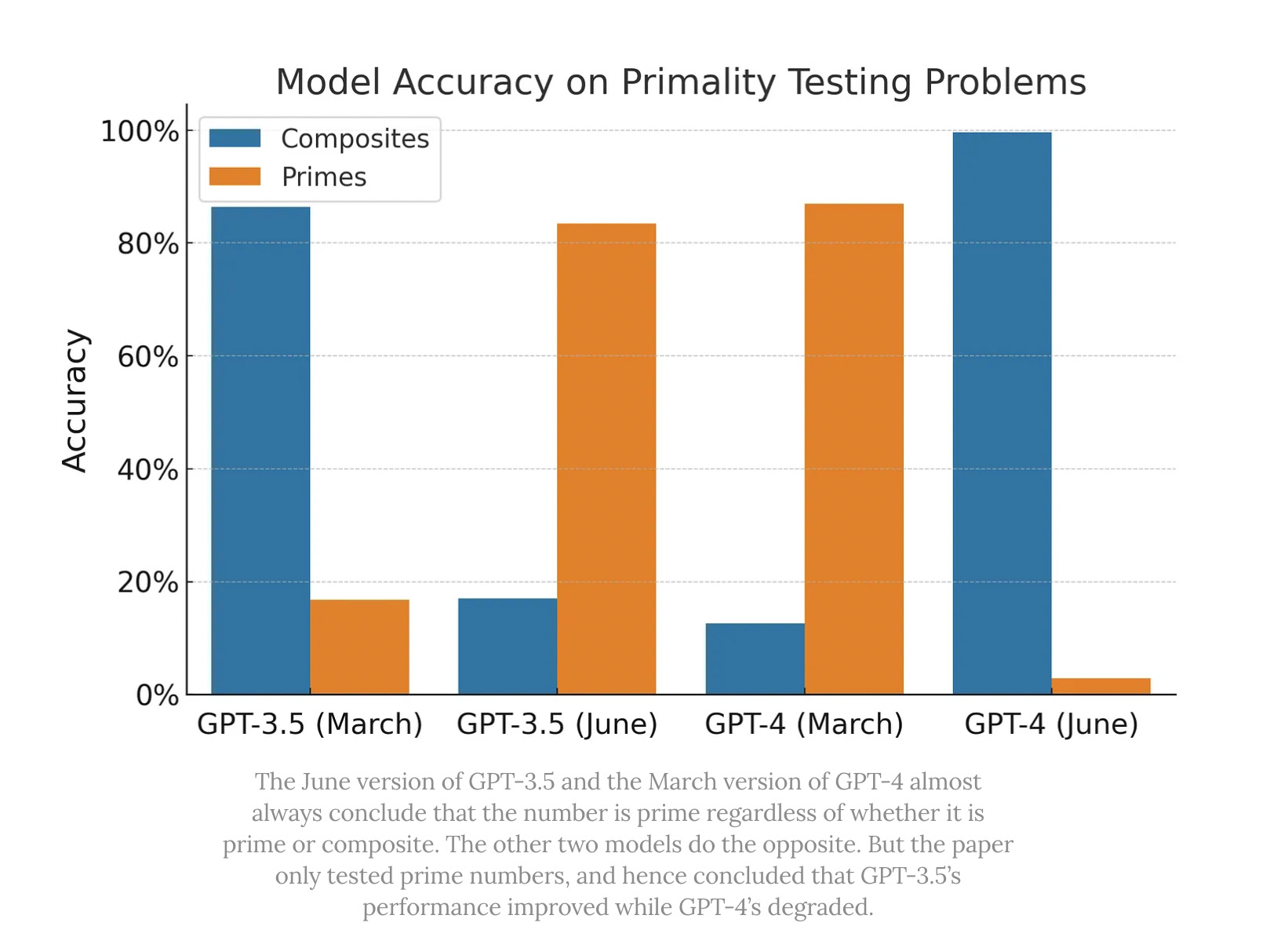

此外,在原始论文中,实验只在素数上运行。在对素数和合数进行测试后,得到了以下结果:

似乎对于GPT-4模型的两个版本来说,它只是简单地猜测是合数还是素数,并且在几个月内更改了它的猜测。这种行为在GPT-3.5模型中也类似。

那么,ChatGPT真的在衰退吗?目前为止,日常使用并没有感觉有什么特别大的变化。如果以前的问题是能解决的,现在还是能解决的。虽然回复的方式可能会不一样,但是只要问的问题足够细节,ChatGPT回复的答案还算可以的。

虽然现在还没有证据表明它的能力有所下降,但有一件事是确定的,那就是它确实正在发生变化,并且由于不是开源的,其代码仍然是一个黑盒子。因此,构建在GPT模型之上的产品可能会随着时间的推移而出现不可预测的变化。随着Llama 2等其他开源模型的兴起, OpenAI正面临着越来越多的竞争。

3. SparseGPT:单个CPU也能运行语言模型!

语言模型是一种非常庞大的模型。它们需要大量的存储空间和计算资源才能运行,并且只能在特定的组织中运行。举个例子,GPT模型拥有1750亿个参数,需要320GB的存储空间,并且至少需要5个A100 GPU,每个GPU内存为80GB,才能进行推理。普通的计算机显然无法处理如此庞大的模型。

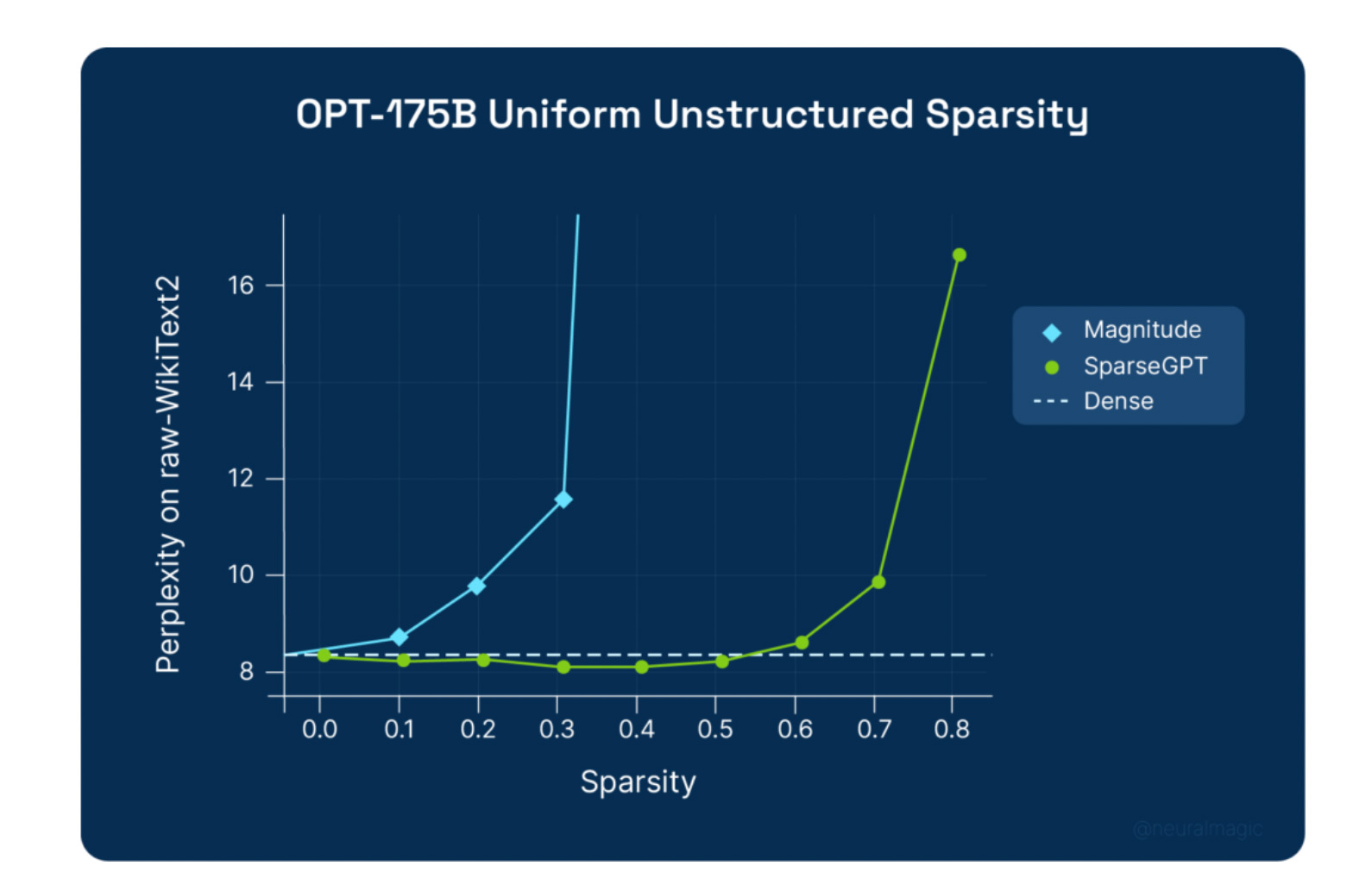

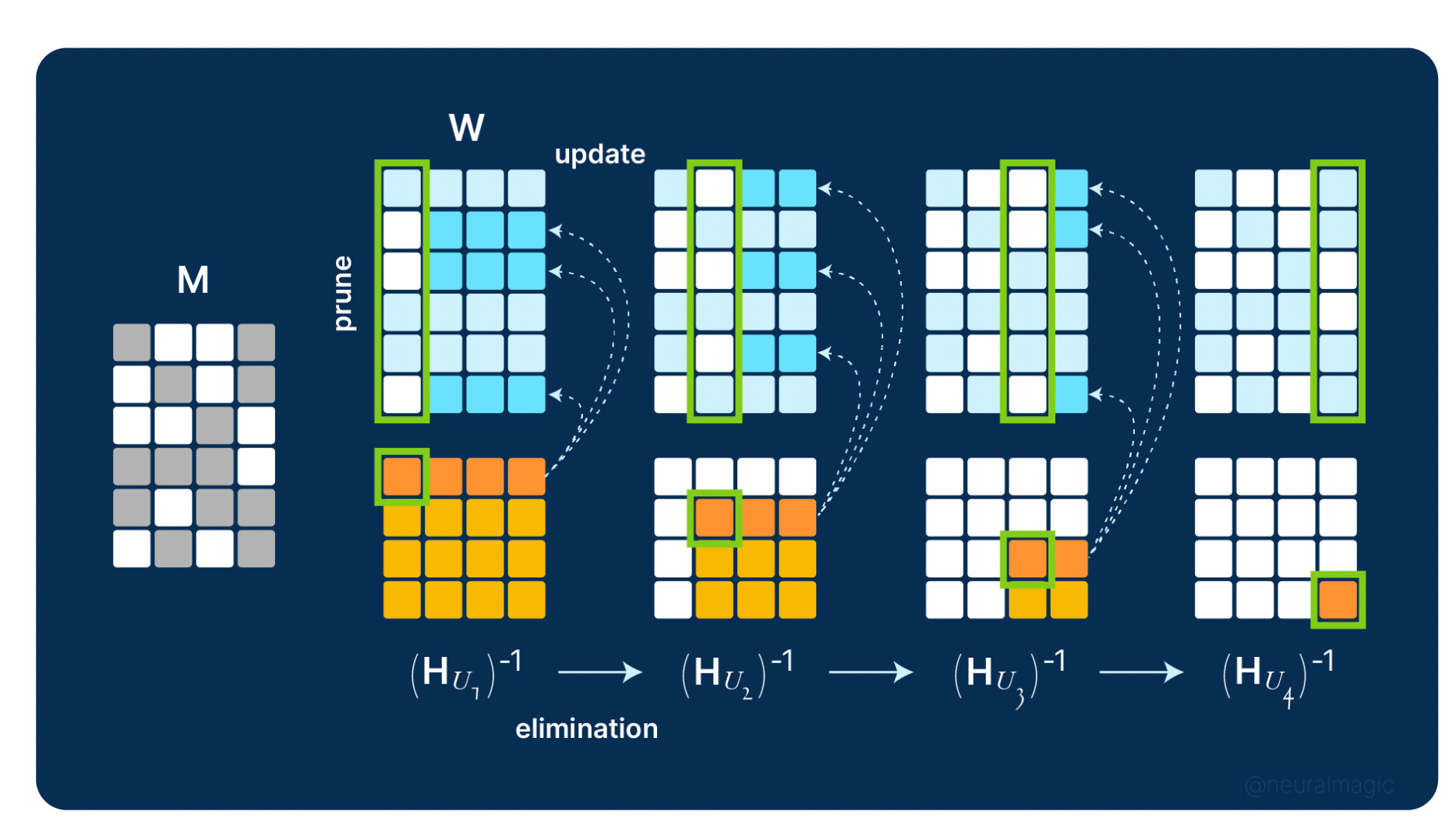

如果我们能够对这些语言模型进行压缩,减少其对计算资源的需求,效果是不是会好一些?个别人提出了几种模型压缩技术,比如量化和修剪。然而,为了保持模型的准确性,这些方法需要大量的训练时间。因此,压缩像GPT-3这样的模型可能需要几周的时间。让我们来介绍一下SparseGPT。它能够高效而准确地修压缩GPT这样的大型语言模型。对于GPT-3模型,SparseGPT能够移除超过1000亿个参数,仅造成0.13的准确性下降。而SparseGPT可以在单个GPU训练整个GPT模型,在几个小时内完成,并且几乎不会损失准确性。

https://neuralmagic.com/blog/sparsegpt-remove-100-billion-parameters-for-free/

https://www.aisnakeoil.com/p/is-gpt-4-getting-worse-over-timehttps://twitter.com/svpino/status/1681614284613099520?t=ETbizTLVyVU6RLMqUkOpkQ&s=19

https://arxiv.org/pdf/2307.09009.pdf

https://www.technologyreview.com/2023/07/14/1076296/mustafa-suleyman-my-new-turing-test-would-see-if-ai-can-make-1-million/