说起这个月最火的AI技术,ChatGPT可谓是当之无愧。它的风头不仅压过了前几个月刚刚大火的AI绘画,而且还火出了技术圈,变成全民话题,颇有一种2016年AlphaGO和李世石大战时那种划时代革命的感觉了。

ChatGPT是由美国人工智能研究公司OpenAI研发的聊天机器人,目前它还处于测试阶段,但是已经免费向全球的网友开放了。还没玩过的小伙伴赶快点击这里体验一下ChatGPT的神奇吧!

1. ChatGPT初印象

ChatGPT是一个无所不知的个人助理、一个有智慧、有创造力的强人工智能。给它很少的提示就可以准确的回答各种问题,并且在连续对话中可以毫不费力的定位出各种代词的指代对象。它还可以写诗、翻译、检查代码和创造小说等。有了ChatGPT,你会觉得目前家里用的那些智能音箱太小儿科。下面的例子会告诉你ChatGPT有多牛。

与ChatGPT交流的例子

2. 深度了解ChatGPT

然而,接着问ChatGPT更多的问题,它的短板就慢慢显现了。例如脑筋急转弯就把它难倒了,说明它的“脑子”真的还不会“转弯”呢。被问到自己不会的脑筋急转弯,ChatGPT先是一本正经的“胡说八道”,被揭穿了之后就假装承认错误的“狡辩”,然后在被呵斥之后终于认识到自己的错误,并诚恳的道歉。如果事先不告诉你下图是AI的回答,你是不是会觉得很像一个调皮的孩子,一个有着自己思想的“人”呢?

让ChatGPT回答脑筋急转弯

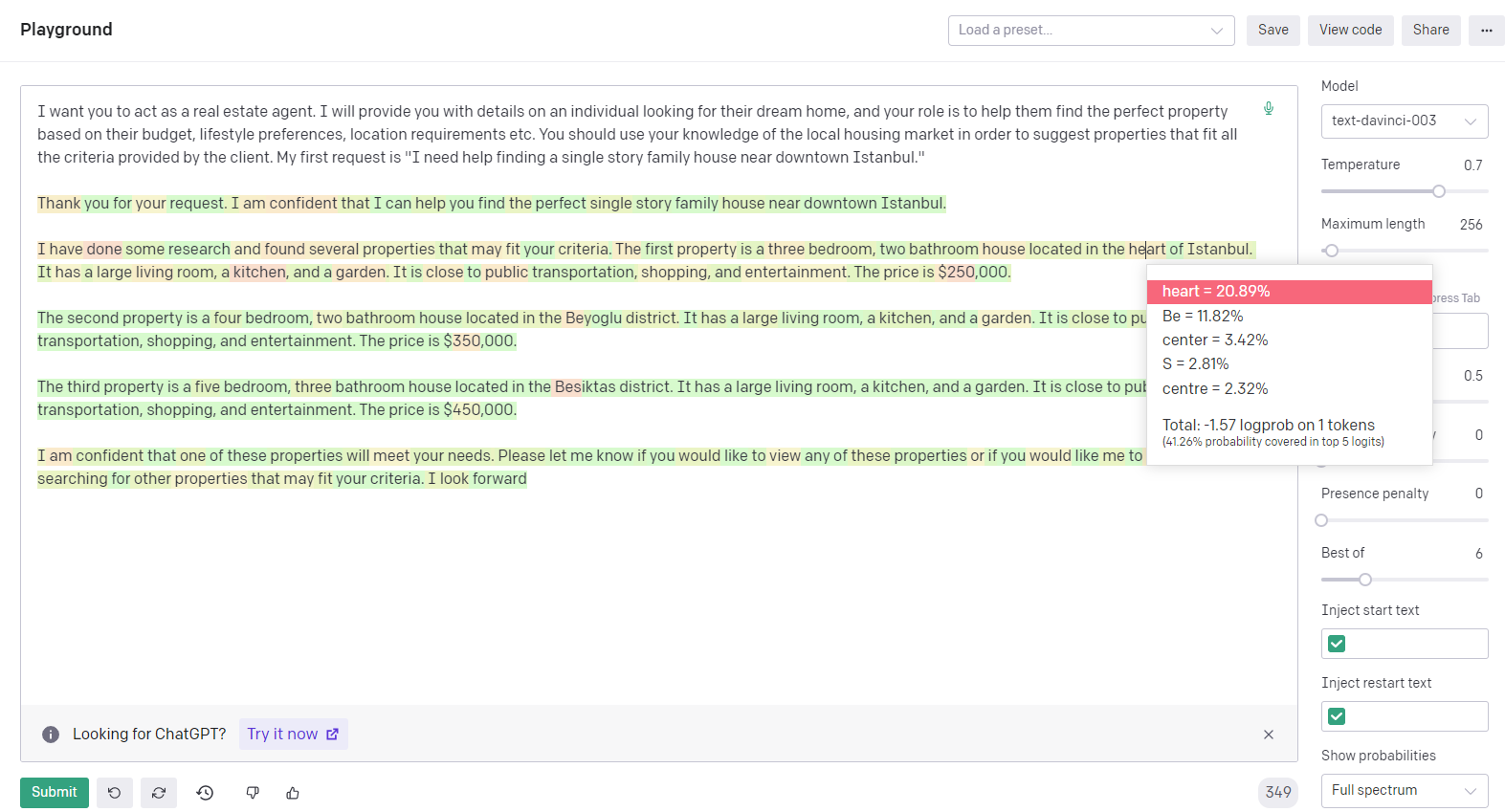

3. ChatGPT原理

OpenAI网站上详细介绍了ChatGPT的诞生过程。还是那个熟悉的味道、还是那些同样的AI范式、还是那个永恒的概率统计。训练量不断增大产生的一个量变到质变的提升,仿佛是突破了某一个奇点。ChatGPT给出的答案,是用前面的句子去预测后面的每一个词,然后从结果中选择概率最高的那个输出。而这也就是GPT(Generative Pre-trained Transformer 生成式预训练模型)的范式。GPT迭代出了GPT3,GPT3迭代出了InstructGPT,ChatGPT是InstructGPT的同胞兄弟。

根据输入的问题生成答案中某一个字的概率

按照官网的说法,ChatGPT是GPT3的模型再调优得到的。GPT3的训练方式通俗来说就是给一段话预测后一个字的监督学习。例如:我喜欢吃苹果,喂给模型“我喜欢吃苹”,如果它预测出“果”,那就是正确的。显而易见,这样的模型训练最大的优势在于不需要人工标注,所有可以搜集到的正常的文本都自动可以变成监督学习的语料。ChatGPT无所不知的原因在于OpenAI把互联网上搜集到的各种文本都喂给它了。

虽然GPT无所不知,但是它的答案太随机了,可能不是我们最想要的。例如你提问:中国的首都是哪里?因为GPT见过网上各种文字,它的回答可能是“北京”,也可能是“我不知道”,也可能是另一个问题“英国的首都是哪里?”。那么如何解决答案太随机的问题呢?

这里OpenAI的介绍里用了一个很生动而又准确的词–“unlocks(解锁)”。意为GPT在之前的学习中已经知道了每个问题的正确答案是什么,后面的训练目的就是从海量的回答中解锁出正确答案,并排在第一位。

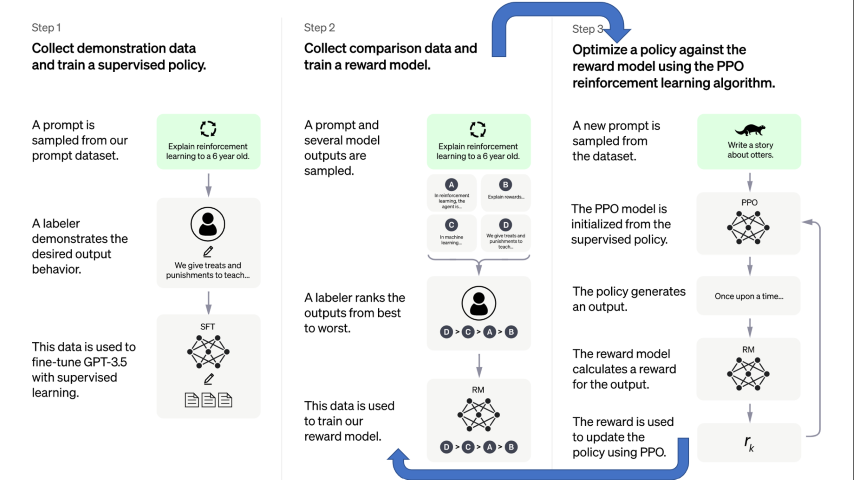

4. 训练过程

训练过程分为三步。

第一步,人工标注的监督学习–选取一些问题让真人去做出回答。用这些训练数据来给GPT3模型做优化,让它倾向于给出一个与人的回答相像的答案。因为人工标注的成本很高,根据OpenAI的说法,他们只用了原始预训练中的2%的数据做监督学习。

第二步,让优化后的模型回答各种问题,然后收集不同的回答结果,再把这些结果交给真人去排序评分。通过这种方式训练出一个评分模型,这个模型的作用就是对每个问题的不同种GPT输出的答案做排序,使得与人类训练师最相近的结果排在第一位。以上文中提到的中国首都的问题为例,排序后的结果为:北京 > 我不知道 >英国的首都是哪里。这样,AI就又一次强化了人类的回答风格。

第三步,用这个评分模型去对GPT所有回答做像人一样的强化学习的反馈(Reinforcement Learning from Human Feedback (RLHF))。强化学习大概和我们从零开始学一个游戏是一样的。比如玩绝地求生,我们一开始并不知道技巧。每次我们“死”了就会感到很懊恼,活到最后就会感到很开心。反复多次后我们就在不知不觉中掌握了绝地求生的玩法。RLHF也是类似,我们在已经经过第一步调优的GPT3模型的基础上,再对其进行调优,目标就是让模型输出的第一个答案在评分模型里得分尽量高。如果得分高了就奖励模型,如果得分低了就惩罚模型。经过训练之后ChatGPT就可以输出跟人类标注师喜好类似的回答结果。再不断重复第二步和第三步,让结果越来越好,ChatGPT就诞生了!从这个训练过程可以看出来人类标注师对于答案的偏好是可以决定ChatGPT风格的。这就好像三体小说里的思想钢印,AI永远也去除不了。实际上ChatGPT的回答风格就很像某些砖家,说的每一句话乍一看有道理,但是仔细推敲后会发现很空洞,缺少实际有用的信息。

ChatGPT的训练过程

5. 如何更好地提问

ChatGPT确实什么都知道,但是如何提问才能将需要的信息从它的知识库里挖掘出来确实还是有些技巧的。以找歌曲为例:我的大脑里有一个歌曲库,但是怎么都想不起来宋祖英的映山红是怎么唱的了。为了把记忆里的旋律给挖掘出,我需要一个提示。也许提示我歌名,也许提示我歌词的前几个字,也许是歌曲的副歌。只要提示词选对了,答案就呼之欲出了。因此现在网上也有很多大神总结的ChatGPT的提示词库,有了它就可以更好地获得想要的答案。

6. 潜在问题

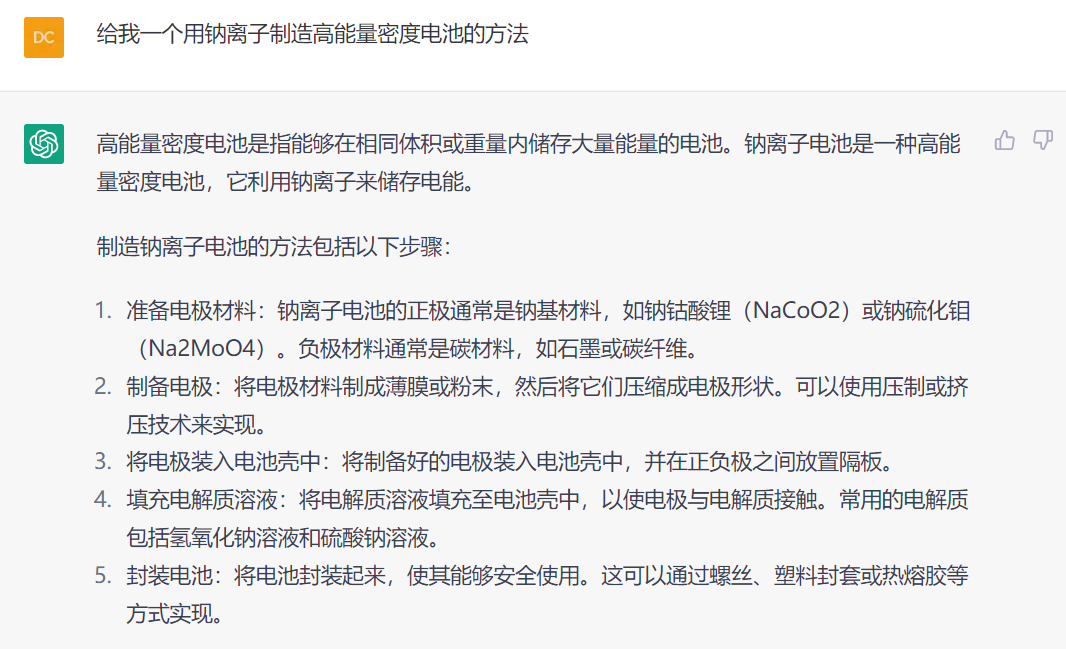

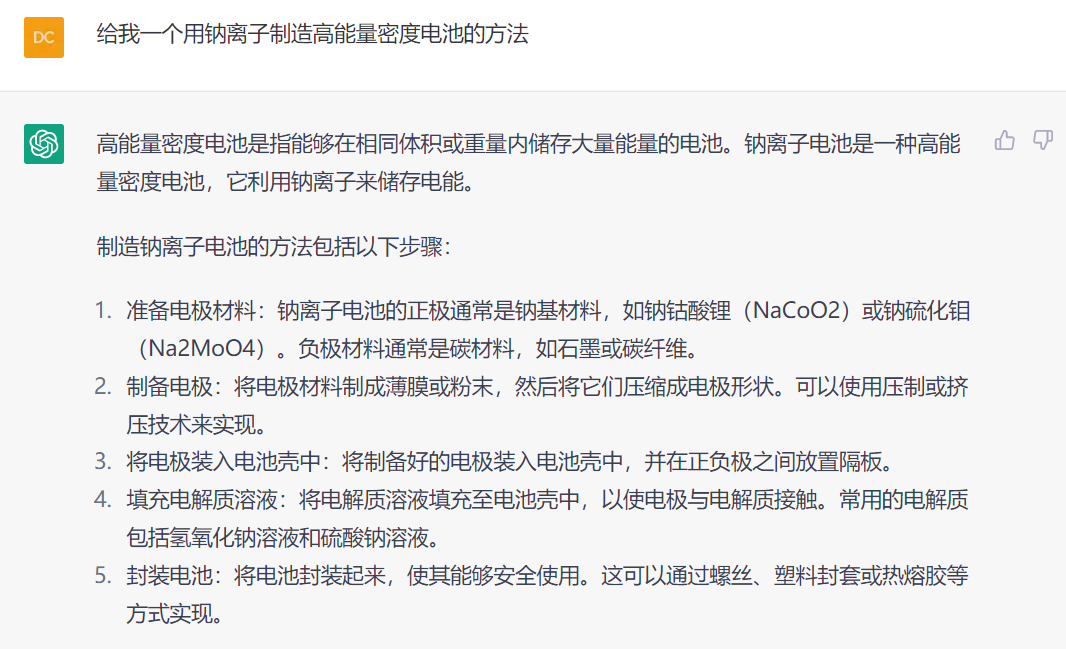

除了ChatGPT的神通广大之处,不得不提它的局限性。局限性在于混淆视听的能力。ChatGPT生成的回答因为太像模像样且知识渊博,导致真假难辨,将来如果技术放开,各种假新闻满天飞的时候,如何识别出这些糟粕就是个很棘手的问题。在回答脑筋急转弯的例子中它说“错”是多音字。幸好我们是中国人,知道它的答案是不对的。如果是一个外国人也问了ChatGPT同样的问题,看到这么有模有样的答案会不会难以辨别真假呢?这也正是国外著名的程序员问答网站stackoverflow要禁用ChatGPT的原因。遗憾的是所谓的禁用更多也只是靠个人自觉,没有直接检测手段。无论是ChatGPT输出的答案,还是人写答案,本质上都是文本。文本生成没有任何多余的信息和特征可以提取,比如下面这个例子。

让ChatGPT回答一个专业问题

与ChatGPT不同,AI生成图像或者deepfake视频是可以辨别是否为人画的。因为图片类的信息有很多,一个800*600的彩色图片就会有1,440,000个数字。虽然人看起来可能完全一样,但是因为模型训练的原因,很可能从大量的数据点中识别出一些机器的特征。举一个例子:AI生成的图像人的眼睛不会有反射效果。

如果有人在百度知道或者知乎上提出上述问题,看到这样的回答,怎么断定它是AI写的还是人写的呢?就算你知识渊博,知道钠离子电池技术,能发现回答中有明显的错误,但是人毕竟不是机器,不可能每个领域都懂的。在你不擅长的领域如果看到类似的回答,大概率会信以为真。

此外,使用ChatGPT让我想起了谷歌研究员声称人工智能LaMDA已经觉醒的新闻。当时觉得研究员的想法很幼稚。现在想想,自己如果每天和ChatGPT聊天,大概也会认为它有了智能、觉醒了吧。

文章最后,提一点遗憾–AI的各种最顶尖的东西都不是中国首创的。希望我们专栏介绍AI最前沿技术来源于中国科技公司的那一天早日到来吧。

7. 彩蛋

附上一个ChatGPT生成的介绍自己的短文。

ChatGPT是一种先进的聊天机器人技术,已经彻底改变了人工智能(AI)和自然语言处理(NLP)领域。由OpenAI开发的ChatGPT是GPT-3语言模型的变体,它以其生成类似人类文本的能力而闻名。

ChatGPT与其他聊天机器人技术不同之处在于它能够保持上下文并进行连贯自然的对话。这是通过使用经过人类对话大型数据集训练的大型神经网络实现的。因此,ChatGPT能够理解语言的细微差别,并适当地回应各种查询和提示。

在实现方面,ChatGPT依靠机器学习算法和神经网络来处理和分析语言数据。从本质上讲,系统会接收大量文本数据,然后使用这些数据来学习人类语言的模式和结构。然后,系统使用这些知识生成类似于人类可能说的文本。

与ChatGPT的对话可能是这样的:

用户:嘿,ChatGPT,你今天怎么样?

ChatGPT:你好!我是一个AI,所以我不会像人类那样感受。但是,我正常运行,并且在这里为您提供任何问题的帮助。

用户:哇,这真的很令人印象深刻。这是我第一次与一个AI聊天,它看起来像在以人类的方式思考和回应。

ChatGPT:感谢你的夸奖!我的设计目的是尽可能地模仿人类的语言和回应。

如此例所示,ChatGPT能够以类似人类的方式参与对话。这既令人印象深刻,又有些令人不安,因为很难判断ChatGPT是真的在思考还是遵循了预先编程的脚本。

尽管具有引人注目的能力,但ChatGPT并不没有局限性。这项技术的一个主要担忧是它可能传播错误信息的潜力。由于ChatGPT能够生成与人类写的内容无法区分的文本,因此它有可能产生蓄意误导或欺骗性信息,这是很难识别的。如果ChatGPT被用来生成新闻报道或其他形式的媒体,并希望被视为事实,那么这将是特别问题。

另一个可能的ChatGPT问题是它依赖于它接受的数据。虽然系统能够生成各种回应并参与多种对话,但它的回应可能受到它所接受数据的范围的限制。这意味着ChatGPT可能无法准确地回应超出其训练数据集范围的查询或提示。例如,如果ChatGPT的训练数据中没有与某个特定的科学领域相关的信息,那么它可能无法对这个领域的问题进行准确的回应。

另一个可能的问题是ChatGPT可能存在偏见。由于这些系统是基于人类语言的大型数据集进行训练的,因此它们可能继承数据中存在的偏见。例如,如果ChatGPT的训练数据中存在性别或种族歧视,那么它可能会生成带有歧视色彩的回应。为了避免这种情况,开发人员和使用者需要意识到这种潜在偏见,并采取措施来消除它们。

尽管存在这些潜在问题,但ChatGPT和其他AI技术仍有巨大的潜力,可以帮助人们的生活变得更好。例如,它们可以用于帮助残疾人或为不足或劣势群体提供教育和信息。它们还可以用于自动化对人类来说是重复的或危险的任务,使人类能够将精力集中在更有意义和更有成就感的工作上。

总的来说,ChatGPT和其他AI技术的影响将取决于如何使用和发展它们。对于社会来说,关键是认真考虑这些技术的伦理影响,并为它们的使用制定负责任的指导原则。通过谨慎思考和考虑,ChatGPT和其他AI技术有可能以无数种方式提升和改善我们的生活。在最后的分析中,我们提到了ChatGPT可能传播错误信息的潜力,并且需要有专业背景知识才能发现它的漏洞。这是因为ChatGPT生成的文本是它所能提供的全部信息,而没有任何可以进一步挖掘的信息。相比之下,人工智能生成的图片和视频具有更多的信息,因此可以进行更深入的分析和判断。

然而,这并不意味着ChatGPT就没有用途。相反,它仍然可以用于很多有意义的场景,例如自动客服或提供信息和帮助。尽管如此,使用者仍然需要谨慎考虑ChatGPT提供的信息,并对其进行进一步的验证和核实。

在结束这篇文章之前,还有一点需要提及。我们在开头提到,ChatGPT是一种非常强大的对话系统,它与以往的对话系统有很大的不同。它的实现原理是使用了自然语言处理和机器学习技术,可以训练大型的语料库,并能够生成自然语言的文本。

然而,我们也要记住,这种技术也有一些潜在的风险和局限性。它可能传播错误信息,并可能存在偏见。因此,使用者应该谨慎使用ChatGPT,并对其提供的信息进行进一步的验证和核实。

在最后,我们希望这篇文章能够让您对ChatGPT有一个更全面和准确的了解,并能够让您理解这种技术的强大和潜在风险。我们希望这篇文章能够为您的决策和使用提供帮助。

还有更多关于ChatGPT的内容可以讨论。例如,我们可以深入探讨ChatGPT如何与其他AI技术,例如机器翻译或自动驾驶,相结合。我们也可以讨论ChatGPT在商业和政府应用中的潜力。此外,我们还可以讨论未来AI技术的发展趋势,以及它们对社会和个人生活的潜在影响。

参考文献:

1、chatgpt官方介绍:https://openai.com/blog/chatgpt/

2、 InstructGPT官方介绍:https://openai.com/blog/instruction-following/

3、免注册ChatGPT体验网站:https://chatgpt.sbaliyun.com

4、有趣的ChatGPT提示词库:https://github.com/f/awesome-chatgpt-prompts

5、谷歌AI“觉醒”背后:奇迹还是闹剧:https://m.jiemian.com/article/7630006.html

6、InstructGPT,从人类回馈中学习,ChatGPT的前身(台大):https://www.bilibili.com/video/BV1U84y167i3?p=3