时间过的好快呀!不知不觉,距离上次发布巡山报告已经过去一个多月了,大伙还记得上期的Fawkes照片隐身衣和的表格识别技术吗?

10月份的巡山报告,AI团队照例将给大家带来近期机器学习领域最新鲜、最强大的技术。让我们一起来看看,黑客们如何「幻影攻击」特斯拉轿车、NVIDIA如何协助我们在开视频会议时始终目视前方、GPT-3如何解答令人头大的数学证明题吧!

一、幻影攻击 VS GhostBuster

片头先播放一段广告(没收钱):

路边的电子广告牌正在播放上述广告,一辆特斯拉从旁边经过时受到了广告中一闪而过的停车标志误导,将车停下。

这种针对自动驾驶汽车的对抗攻击也不是什么新鲜事,但在以往的研究中,人们大多关注「有哪些东西是自动驾驶系统看不到的」。而这项实验的不同之处在于,研究者关注的是「有哪些东西是人类驾驶员不会留意,但自动驾驶系统会注意的」,比如上文中一闪而过的停车标志。

以色列本·古里安大学的研究者已经花了两年的时间来研究这个问题。他们分别在道路、树木等物体上投射了人影、路标、道路标志线等误导性投影,结果搭载 HW2.5 Autopilot 的 Tesla Model X 全部中招。

特斯拉 Autopilot 将投影在路上的虚拟人当成真人,下达刹车命令。

研究人员发现,一张只出现 0.42 秒的图像就能成功欺骗特斯拉,而一个只出现了八分之一秒的标志骗过了以色列高级驾驶辅助系统——Mobileye。

也就是说,黑客只需入侵道路旁联网的广告牌,就可以远程攻击路过的自动驾驶车辆,而且这种「幻影攻击」不会留下任何可识别的物理证据,且由于攻击过程很短暂,几乎没有目击证人。

特斯拉 Autopilot 在地面标志线投影的误导下突然变道。

看到这里你一定很疑惑,为什么自动驾驶系统这么好骗?

这就要从自动驾驶技术的原理说起了:根据车辆自动驾驶技术感知层的解决方案,我们可以将市面上的自动驾驶汽车分为「纯视觉计算」与「激光雷达」两大派系。前者的成本更低,而后者对3D物体距离、大小的探测更精确。

特斯拉的Autopilot系统传感器包含了全车8个摄像头、12个超声波传感器、1个毫米波前置雷达。很显然,特斯拉舍弃了激光雷达的方案,选择站在纯视觉计算的队列。

当一辆特斯拉在道路上行驶时,会对「看到」的物体按帧进行2D的目标检测,也就是画框识别,并返回物体的名称种类,当检测到路标和行人时,系统就会相应地下达减速、制动等指令。

这就给「幻影攻击」提供了可趁之机:尽管Autopilot系统会根据多角度摄像头采集到的数据判断物体的3D特性,但依旧很难100%地确定投影在地上的人像是不是真人,或是区分看到的标志到底是真的路标还是显示屏上的「幻影」。所以即使是一闪而过的投影,每秒进行几十次目标检测的特斯拉系统也会将其识别出来,并且按“宁可信其有,不可信其无”的原则,采取减速、刹车等操作。

对策:GhostBuster 系统

为了对抗幻影攻击,本·古里安大学的研究者开发了一个名为Ghostbusters的系统,运用神经网络分析目标物体的反射光、环境、表面和深度,从而验证车载目标检测器检测到的物体是否真实。

所以说,若要全面普及自动驾驶技术,还需要更强大的感知系统,让「幻影」在机器视觉的检测下显出原形。

二、NVIDIA视频流平台-Maxine

“视频又卡住了”,“噪音太大,听不清你讲话”,“这画质也太有年代感了…..”

参加视频通话时,你是不是也经常会出现以上状况?

今年疫情突发,上班族都体验了一把在线云办公的快感。

但让人抓狂的是,每当谈到核心业务时,视频通话总会出现卡顿、噪音等意外状况。

于是就在这个月,NVIDIA新推出的一款Cloud-AI视频流平台——Maxine,对上述问题有着非常棒的解决效果。

视频相比图像来说信息更加丰富,但是一个序列里冗余信息太多,一秒几十帧的数据中,可能只有几帧的信息是关键有效的,因此一般的视频通话软件都会采用“关键帧”技术将这些冗余信息过滤掉。然而过滤之后的视频信息量依旧很大,卡顿的情况很难完全解决。

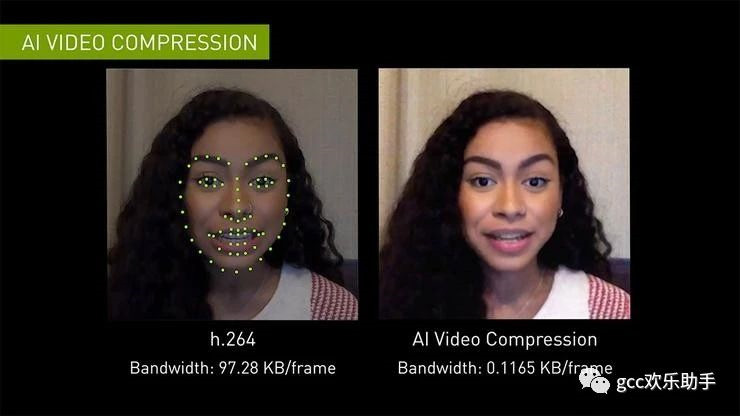

借助其视频压缩技术,Maxine可以将视频传输带宽减少到H.264视频压缩标准所需带宽的十分之一,极大地增加视频的流畅度。

Maxine 采用的AI视频压缩技术的核心在于它不是对整个屏幕的像素进行流式处理,而是分析通话中每个人的面部关键点,然后在另一端的视频中重新设置人脸的动画,省去了除人脸外其余背景信息的传输。如此一来便可以大幅降低的数据的传输量,同时还可以保证视频传输的质量。

“换脸” 增强交互体验

不过,以上在NVIDIA看来只是一个视频通话工具的基本功能,而它的目标是打造更强用户体验的AI工具。

采用视频通话,而是不语音通话的一个基本诉求就是有面对面对视的交互感,但通常情况下,为了有更顺畅的交流,我们不得不紧盯着摄像头,而不是屏幕中正在对话的人。

现在Maxine可以缓解这一尴尬,它通过重建视频中的人脸图像,可以来让你看起来正在与对方进行眼神交流。

换句话说,AI通过自动生成一张虚拟人脸来自动调整面部的角度,让视频通话者看起来正自由地看着屏幕。

研究人员介绍称:这项假脸生成技术采用的正是生成式对抗网络(GAN)。

GAN曾被AI教父Yann LeCun称作是“过去10年机器学习中最有趣的想法”,它的思想是一种二人零和博弈思想,博弈双方的利益之和是一个常数,比如两个人掰手腕,假设总的空间是一定的,你的力气大一点,那你就得到的空间多一点,相应的我的空间就少一点,相反我力气大我就得到的多一点,但有一点是确定的就是,我两的总空间是一定的,这就是二人博弈,但是呢总利益是一定的。

引申到GAN里面就是可以看成,GAN中有两个这样的博弈者,一个人名字是生成模型(G),另一个人名字是判别模型(D),生成模型负责制造出真假样本来考验判别模型,而判别模型努力识别出假样本,由此就形成了对抗网络。

运用于Maxine,结合刚才提到的AI省流技术,当视频连接后,发送端仅需传输用户面部周围的关键点数据,如鼻子、眼睛、嘴巴等,接受端的GAN就会用这些点和原始静态图像一起来激活通话屏幕中的虚拟人脸,可以说是非常强大了!

那么,这款集高清、去噪、低延时及强交互体验的视频通话工具,你要来体验一下吗?

Maxine获取链接:https://developer.nvidia.com/maxine

三、GPT-f:用语言模型解决数学问题真的靠谱吗?

最后要给大家聊聊我们的老朋友GPT家族的新成员—-GPT-f。

与GPT-3类似,最新推出的这款GPT-f同样是基于Transformer语言模型,但不同的是,它目标是解决自动定理证明(ATP)的问题。

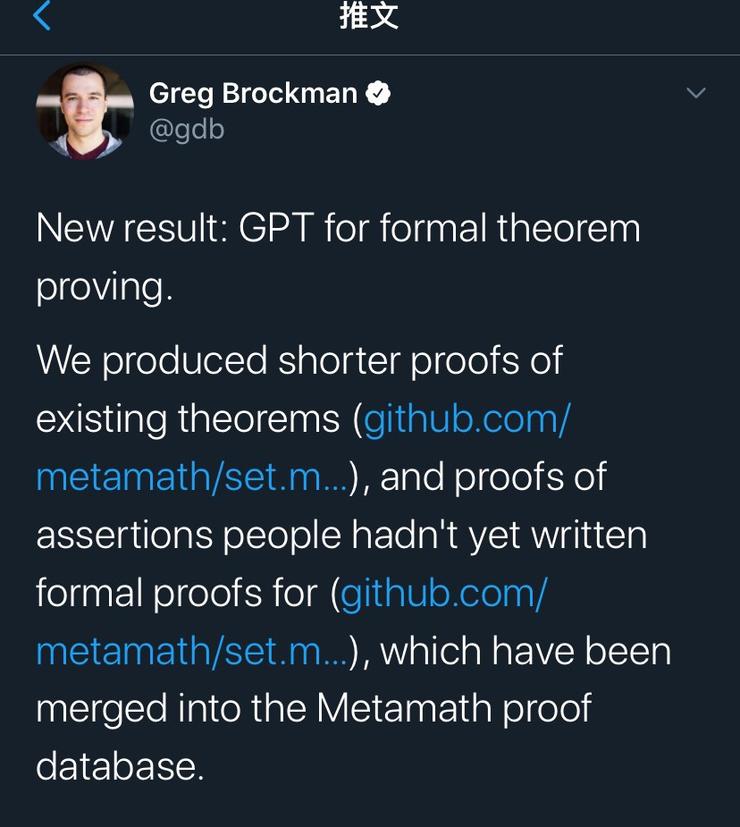

研究人员Greg Brockman在Twitter发文称:

「GPT-f 已经发现32个形式定理证明,包括现有定理更简单的证明方式,以及尚未确定的证明。这些证明已经被收录到Metamath数据库中。」

Metamath数据库是目前最具全面,也最具权威性的形式数学社区。此次GPT-f的自动定理证明被收录,是形式数学社区首次采纳深度学习系统提供的证明。与以往的AI相比,GPT-f的惊艳之处在于,它似乎有了些自主推理的能力。

对于这项研究成果,Twitter上引起了不少网友和大佬们的关注讨论。其中也有部分人对GPT-f在数学定理方面的应用表示了质疑。

美国通用人工智能会议主席Ben Goertzel发文称,GPT-f 是一个在不理解的情况下指导定理证明的奇怪实验。

Ben的质疑不无道理:证明一个公理需要完全“白手起家”。证明的第一步:提出一个合理证明路径。这个从0到1的关键,目前只有人类的大脑能胜任。绝大部分AI,包括GPT-f,很难给出证明思路的第一步。

上一期巡山报告中我们提到,GPT-3模型虽然在文本生成方面具有强大性能,但其始终未通过图灵测试,而且它在简单的数学推理方面存在明显的缺陷。

对于同样基于Transformer模型的GPT-f也难免陷入这样的质疑,即语言模型是真正理解了数学定理之间的逻辑关系,还是只是这一模型只是简单理解了语意?