端午已过,梅雨将歇。火热的夏日和毛茸茸的暑假正在向我们扑过来。让我们一起来看看近期AI届发生的有意思的事情吧!

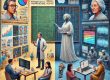

1. 谷歌最新图像工具,让AI控制风吹草动

自然界是运动的,即使看似静止的场景也会因风、水流、呼吸或其他自然节奏而包含微妙的振荡。模拟这种震荡在视觉内容合成中至关重要——人类对运动的敏感性会导致没有震荡的图像看起来不真实。为了让图像更为真实的动起来,谷歌的研究者提出了Generative Image Dynamics方法。(上图为该方法生成的无缝循环视频和交互式视频)

令人欣喜的是,这种方法可以通过调整运动纹理的幅度来缩小或放大运动幅度,也可以指定不同的方向,让物体沿着指定方向模拟交互式运动。

上排图像的运动幅度比下排的小

模拟交互式运动

交互式体验的章节中附上了三张图片,可以通过拖拽的方式让图片动起来。

编者也尝试玩了一会儿研究团队提供的demo,总体来说,动态的效果很棒,但回弹的速度无法控制,会比较快的回弹回去,并且振动幅度会快速降低,很快的停下来,像是真的被人扯了一下;在试用树木的图片时,编者还发现在不同方向上树枝能被扯动的幅度是不一样的,且在大幅度扯动时前景边缘会出现变形和粘连的情况。不过团队也提到为了渲染速度考虑,demo使用的模型并不是论文中提到的高质量模型。

让我们一起期待模型的不断改进和迭代,也期待它最终开源的那一天~

2. 淘宝AI试衣,因为“自由度太高”被玩坏了

去年,淘宝上线了“AI试衣间”的功能,网友可以填写体重、身高、身型、肤色等相关数据,生成数字人形象进行试穿。不过,这项功能起初并没有什么大水花,直到近期,这个试衣间额外附加了一个功能——用户可以导入自己的照片,来增加线上试衣的真实感。

于是,淘宝“AI试衣”功能突然就在社交媒体上火了起来。但相比正儿八经的试衣,这项功能更为网友看重的主要作用是快乐的整活。

在各方网友的精心挑选下,无论是齐天大圣,健身达人,还是动漫游戏中的小哥哥们,最终都逃不过各式花哨性感的女装。原本旨在提升购物体验,减少服装退换的AI试衣功能,也因网友的“花式整活”而走红。

但是除去娱乐的成分,AI试衣真的实用吗?答案是否定的。有网友表示“AI试衣底层还是照骗”,甚至有网友晒出了试穿和实穿的对比图,从版型到材质,AI试衣都很难成为一个成熟的参考依据。

来源:B站用户@153cm微胖朱朱

左为AI试衣效果图,右为上身真实效果图

编者也去淘宝尝试了一下AI试衣功能,总体体验下来感觉整活的乐趣大于它的实用性,改变身高得到的试穿效果相差不大,甚至有时会出现穿模或者边缘残缺的情况,也不太能体现衣服的版型,垂感等在实际人身上的效果,身型也只有简单的几种可以选择。缺失了肩宽,三维等更具体的身材比例,试衣的可靠性也值得怀疑。

想尝试的小伙伴可以在手机淘宝app中搜索淘宝试衣,再点击顶部进入频道,就可以上传自己(或者你推)的半身/全身照,选择喜欢的衣服进行试穿啦~

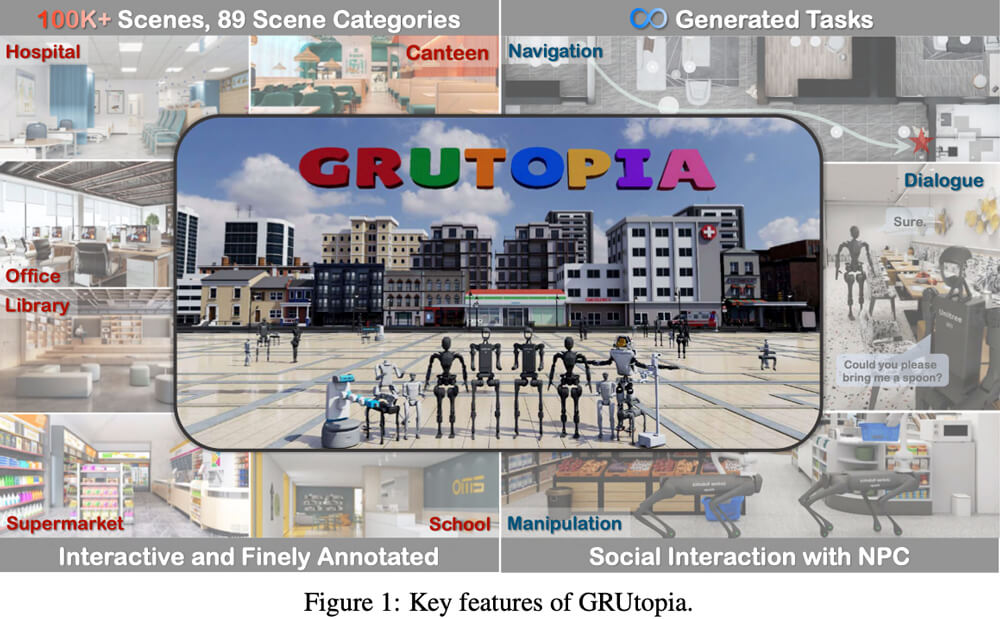

3. “人机共生”的“桃源”来了!

还记得我们去年提到过的斯坦福的 AI 小镇吗?这是斯坦福的 AI 研究者打造的一个虚拟环境。在这个小镇上生活着25个AI智能体,它们各自拥有自己的个性和背景故事,正常生活、工作、社交,甚至谈恋爱。智能体的行为和记忆通过大语言模型来驱动,这些模型能够存储和检索智能体的经历,并根据这些记忆来规划行动。

而最近,来自上海人工智能实验室等机构的一批研究者也打造了一个虚拟小镇GRUtopia。不过,与斯坦福小镇不同的是,这个3D小镇包含了10万个交互式场景和89种不同的场景类别,达到了城市规模,是首个专为各种机器人设计的模拟互动 3D 社会。

研究团队表示,GRUtopia的设计主要是为了解决具身智能领域数据稀缺的问题。它的目的是为机器人学习和测试提供一个大规模互动的3D城市环境。整个虚拟小镇主要由三个主要部分组成:

GRScenes:

GRScenes是大规模场景数据集,包括10万个可以互动的场景,涵盖了从家庭内外到公共空间的各种环境。每个场景都具有物理上真实的材料、详细的外观和可访问的内部结构,并具备详细的注释标签。此外,研究团队还专门请了设计师布置家具,以便让家居布局更贴合人类的使用习惯。

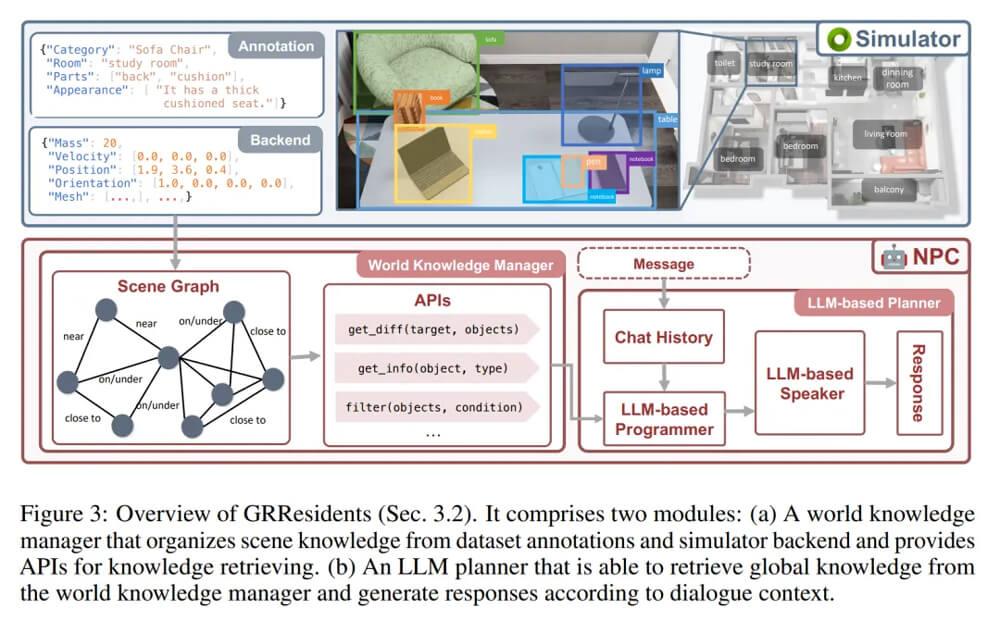

GRResidents:

GRResidents是由大型语言模型(LLM)驱动的非玩家角色(NPC)系统,用于模拟城市环境中的社交互动。为了增强NPC的感知能力,团队设计了一个世界知识管理器(WKM),用于管理实时世界状态的动态知识。借助 WKM,NPC 可以检索所有的知识,轻松访问场景注释和虚拟世界的各种状态。

NPC的决策则通过一个基于 LLM 的规划器进行。这个规划起可以分为三个部分(如图 3):存储模块,用于存储 NPC 与其他智能体之间的聊天历史记录;LLM 程序员,使用 WKM 来查询场景知识;LLM 发言器,用于消化聊天历史记录和查询到的知识,并据此生成回复。

当一个 NPC 收到一条信息时,它会首先将信息存储在存储模块中,再将更新的历史记录转发给程序员。然后,程序员会查询必要的场景知识,最后将知识和历史记录发送给发言器,由其生成响应。

GRResidents将LLM框架与场景感知模块结合,实现了与用户的动态对话和任务分配。NPC可以推断物体之间的空间关系、理解场景语义、观察其他代理的活动,并基于这些信息进行交互。

GRBench:

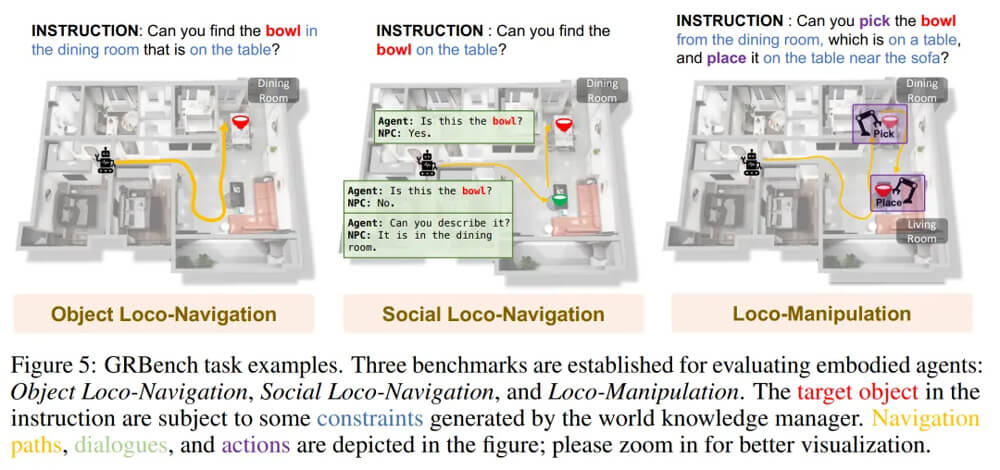

GRBench是一个基准测试框架,主要针对腿式机器人设定了三种任务以评估机器人在不同方面的能力。以下是这三个任务的具体介绍。

物体本地导航(Object Loco-Navigation):机器人需要根据给定的语言导航到目标物体。

社交本地导航(Social Loco-Navigation):机器人需要通过与NPC对话澄清模糊的指令,并导航到目标物体。

本地操控(Loco-Manipulation):机器人需要拾取和放置物体,包括从初始位置拾取目标物体,并将其放置在指定位置。

下图是 GRBench 的一些任务示例。

物体和社交本地导航任务的成功标准都是目标物体出现在机器人视野中且距离小于3米,本地操控任务的成功标准则是目标物体最终被放置在满足所有任务条件的位置。

GRUtopia的提出为嵌入式人工智能的研究提供了一个创新的模拟平台,它为具身智能的测试和评估提供了城市规模的具有多样化功能场景的环境(GRScenes),用于各种嵌入式控制的学习型API,以及能够进行社会互动、任务生成和分配的多模态NPC系统。

虽然初步发布的场景仅限100个,发布的功能也相对有限,且目前NPC系统支持社会互动,但缺乏物理接触的真实模拟,但编者相信未来的研究者会在GRUtopia的基础上进一步拓展场景类型和规模,提高系统的仿真性和功能性。或许在不久的将来,机器人将从“桃源”跨入我们的生活,切实的为我们的日常生活带来便利和帮助。

1. https://arxiv.org/pdf/2407.10943

2. https://tinyurl.com/mr3t8n2y

3. https://tinyurl.com/3j8rbxba

4. https://tinyurl.com/cfvuhkzd

5. https://tinyurl.com/2bk2hb9v

6. https://tinyurl.com/3rbj2437