新的一年开始了!祝大家新年快乐!让我们来看看近期AI界有趣的事情吧!

“ Vesuvius Challenge被提出,目的是借助其他领域的知识解决恢复文字的问题,参赛者使用机器学习算法,从烧焦的卷轴中恢复出一部分文字。Gemini 1.5的上下文长度达到了惊人的10m tokens。数据中心的耗能每年就占到了全球耗能的1%~1.5%。”

1. AI挑战火山

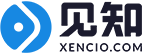

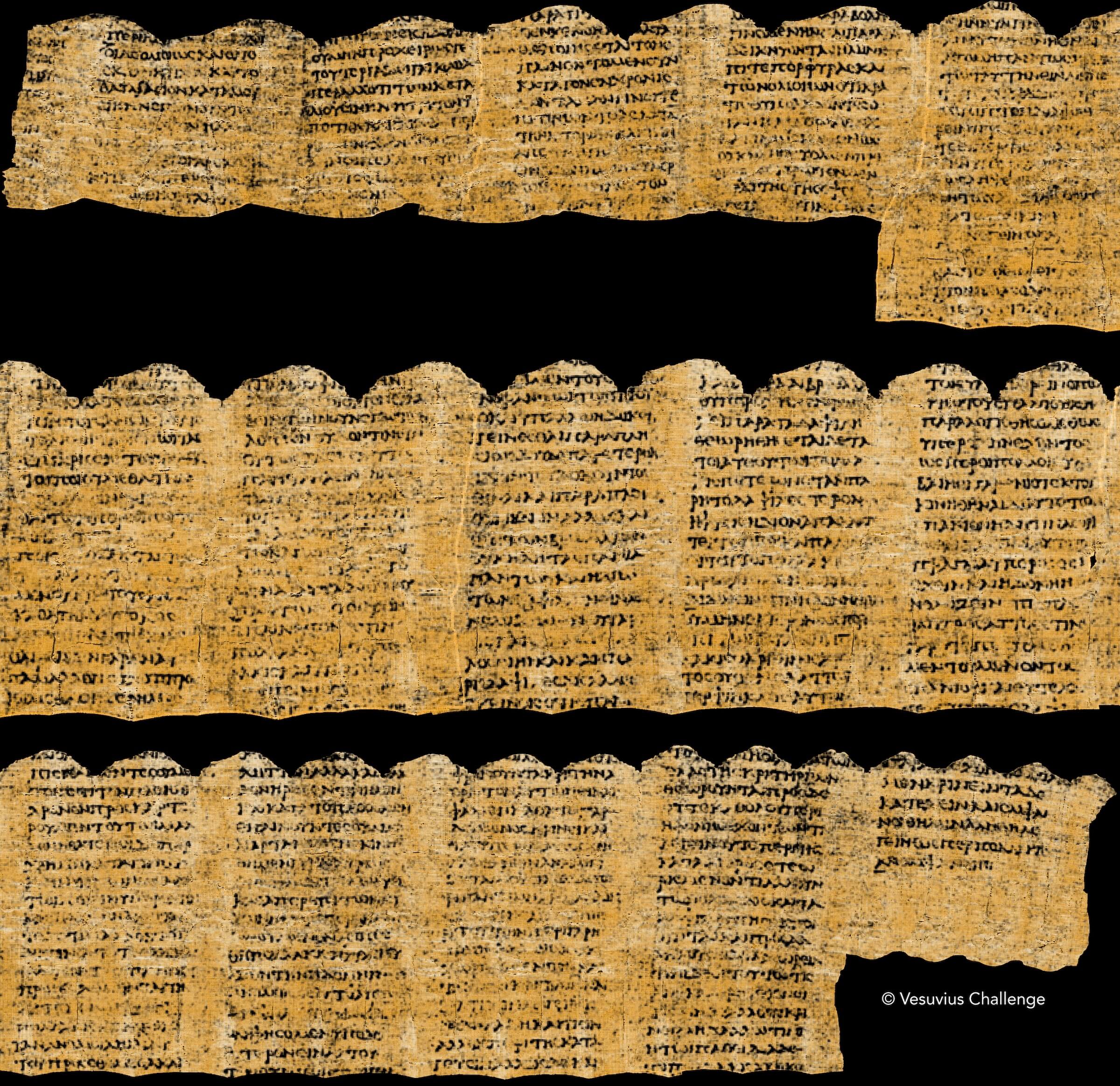

相信大家都听说过庞贝古城,维苏威火山的爆发使这座城市毁于一旦。火山爆发对庞贝的毁灭性打击还在文化层面,古城中有一座图书馆,里面存储的大量卷轴在火山爆发时被烧焦,并被埋没在火山灰里。

卷轴被火山灰埋没

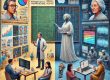

这些烧焦的卷轴在19世纪被当地的农民发现,卷轴已经被碳化,十分脆弱,一旦尝试打开就会完全毁坏,200多年来,考古学家们对于解读卷轴中的内容无能为力。

试图打开卷轴会导致卷轴的完全毁坏

这些卷轴中的内容和可能和当地的文化息息相关,如果可以解读出来,这将是考古学中的重大发现,可以极大地丰富人们对于当时文化的认识。在2023年3月15日,Vesuvius Challenge被提出,目的是借助其他领域的知识解决恢复文字的问题。主办方给烧焦的卷轴进行CT扫描,再将扫描结果展开为立体图,参赛者们根据这张立体图找出恢复字迹的解决方案。这个挑战在2023年底得到了进展,参赛者使用机器学习算法,从烧焦的卷轴中恢复出一部分文字了。考虑到焦黑一片的卷轴,恢复的效果相当惊人。值得一提的是,比赛的冠军是一名本科生、一名硕士生和一名博士生组成的团队。

恢复的结果图

然而,在网络上很多文章采用的标题是:”Inside the AI-Powered Race to Decode Ancient Roman Scrolls”,意思是说使用AI方法解读古罗马卷轴,虽然意思上是对的,但是很容易让人误解为使用AI方法翻译古罗马文字。笔者一开始就上当了,直到看了原文才知道卷轴其实已经烧焦了。所以还是要用实证的眼光处理信息,不要仅看个标题,这样很容易被误导。

2. Gemini 1.5:超长上下文模型

2月15日,谷歌发布了超长上下文多模态MoE大模型Gemini 1.5。可以把大语言模型的“长上下文”理解为人的记忆。常说老者具有智慧,这是因为老者人生阅历丰富,记忆丰富。对于大语言模型,更长的上下文窗口让模型能够记忆更多信息、提升对信息的理解程度、在推理时融合更多新的、特定任务的信息,从而在各种任务中提高性能。

Gemini 1.5的上下文长度相比于其他大语言模型具有显著优势。Anthropic 的Claude 2.1模型上下文长为200k tokens,OpenAI的GPT-4-Turbo达到了128k tokens。所谓的tokens,可以简单地理解为一个和字数成正比的量。Gemini 1.5的上下文长度达到了惊人的10m tokens。

下面的例子充分说明了Gemini 1.5的长上下文优势。谷歌的开发者使用Gemini 1.5学习翻译Kalamang,这是一种语言,全世界说这种语言的人数不会超过200人,关于这门语言现存的文件只有500页的语法,2000个单词构成的简短词典以及400句句子,总共约为250k tokens。

Kalamang是印度尼西亚东部一村落的语言

这项挑战可以很好地测试Gemini 1.5的长上下文能力,因为说Kalamang的人很少,网络上几乎不会存在关于Kalamang的内容,因此Gemini在训练过程中几乎没有接触到关于Kalamang的内容,完全是根据输入的文件进行翻译。

谷歌的研究者将Gemini 1.5和Claude 2.1与GPT-4-Turbo比较,后两者会出现上下文长度小,无法记忆所有文件。输入一半的文件下和输入所有的文件后,让一个不了解Kalamang的人根据参考资料翻译,并且给三个模型的翻译结果打分,得到Gemini的表现比Claude和GPT-4-Turbo都好,且接近打分者根据参考资料的翻译的表现。

这个例子说明了Gemini在拯救和复兴濒危语言上有很大的应用前景,也说明了Gemini上下文长度的优势,适用于处理特定的、在网络上出现少的问题。

3. AI和能源

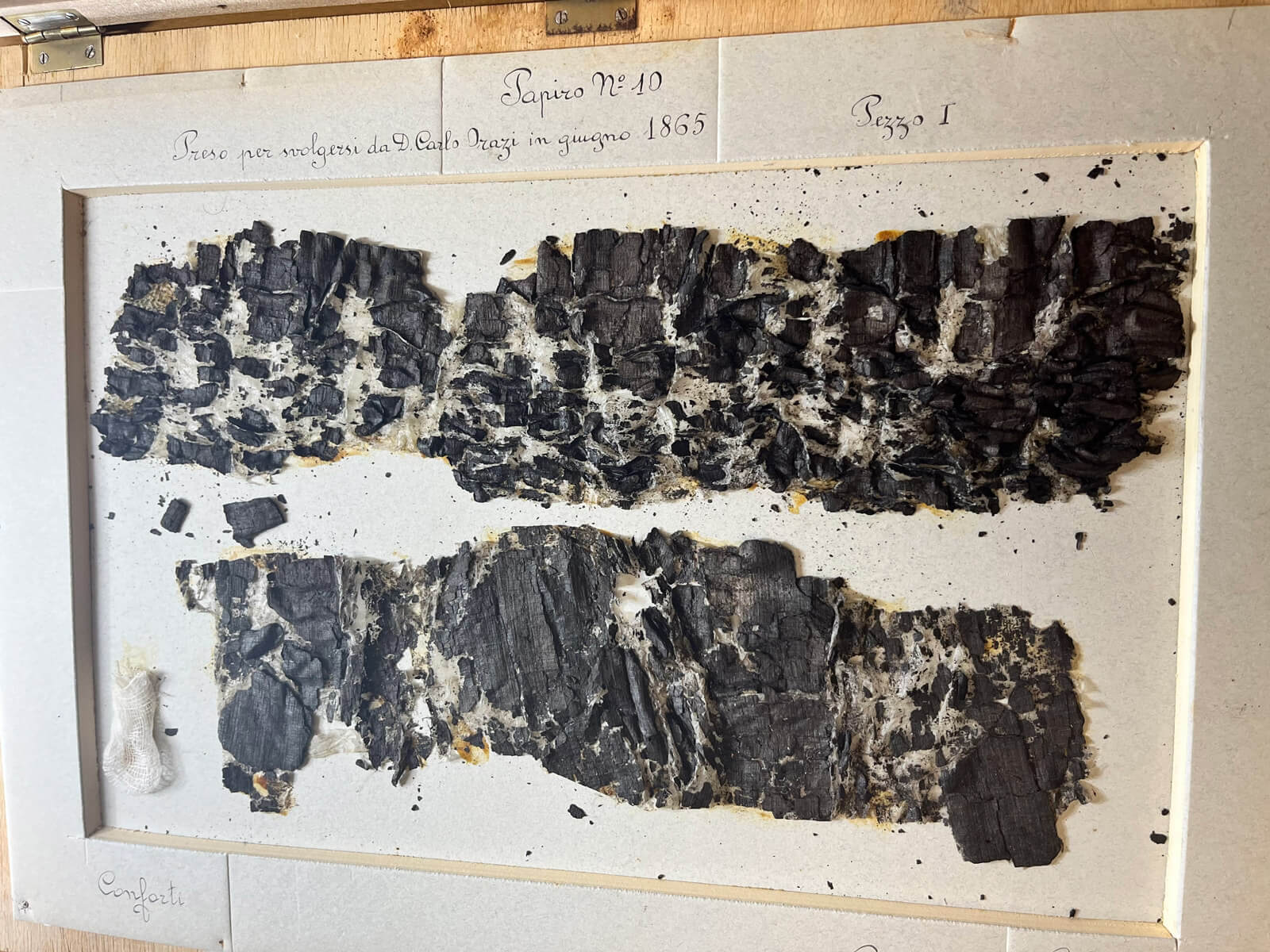

算力是人工智能行业不可或缺的一环,没有足够的算力,人工智能算法就难以得到理想的结果。要想获得足够的算力,需要建造大型的数据中心,里面放了大量GPU运行人工智能算法。

数据中心的计算集群

然而,困扰着工程师们的不是算法,也不是GPU,而是一个传统的问题,这是一个在人工智能行业中较少被提及的话题:大型的数据中心耗能太高。事实上,数据中心的耗能每年就占到了全球耗能的1%~1.5%,而且这个比例随着人工智能行业的全面发展会继续上升。

“We still don’t appreciate the energy needs of AI technology. There’s no way to get there without a breakthrough.” — Sam Altman, CEO, OpenAI, on January 16, 2024

一些公司,例如Meta,正在计划用传统的化石能源作为能源补充,另一些公司,例如Microsoft,正在计划使用小型的核反应堆提供数据中心的能源。但是这两种方案都有问题,前者会增加温室气体的排放,后者的稳定性值得商榷。

增加能源的供给量只是一个暂时的策略,因为人工智能行业的耗能会随着这个行业的增长不断扩大,到时候需要的额外能源会随之增长。需要通过设计更高效的算法、更高效的硬件来实现减少能耗。

1. https://scrollprize.org/grandprize

2. https://deepmind.google/technologies/gemini/#introduction

3. https://www.deeplearning.ai/the-batch/ai-electricity-demands-spur-an-expansion-of-power-sources