说起这个月最火的AI技术,ChatGPT可谓是当之无愧。它的风头不仅压过了前几个月刚刚大火的AI绘画,而且还火出了技术圈,变成全民话题,颇有一种2016年AlphaGO和李世石大战时那种划时代革命的感觉了。

ChatGPT是由美国人工智能研究公司OpenAI研发的聊天机器人,目前它还处于测试阶段,但是已经免费向全球的网友开放了。还没玩过的小伙伴赶快点击这里体验一下ChatGPT的神奇吧!

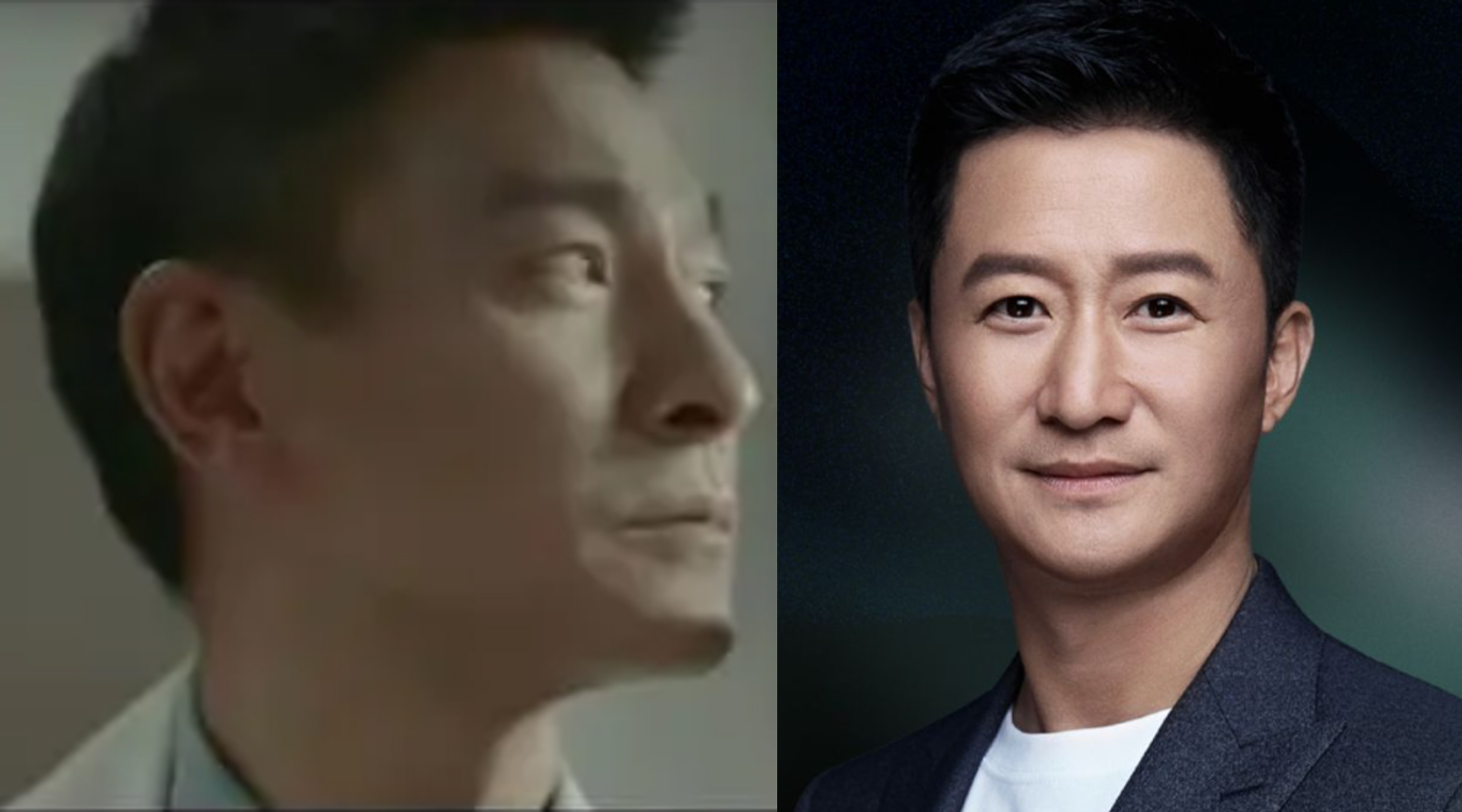

1. Deepfake in《流浪地球2》

相信很多小伙伴都已经看过或是准备去看春节档爆火的《流浪地球2》了,仅仅上映了十天时间,这部电影的票房就已经超过28亿了。除了引人入胜的剧情,震撼人心的特效以外,这部电影让小编印象最深的还是那两位“年轻版吴京”和“年轻版刘德华”。

图一:《流浪地球2》中的年轻版刘德华和年轻版吴京

初看的时候小编和很多网友一样,还以为是靠的是 “东方邪术”,却没想到官方透露说,这是通过一种名叫Deepfake的AI技术实现的De-aging数字换龄。

图二:b站网友的评论

De-aging 是一种应用于影视作品的视觉特效技术,是指利用数字编辑 (digitally editing) 或计算机绘图 (computer graphics,简称 CG) 技术,实现演员在特定场景下的年轻化。

当前世界上存在三种主流的de-aging方法,一是完全由电脑生成,首先制作出演员的数字人,然后基于动作捕捉设备生成动画;二是仅由电脑生成脸部,这种方法不需要佩戴额外的物理设备,有些类似于用ps修改原视频;三是基于Deepfake算法生成,也就是《流浪地球2》剧组的选择,相比于前两者而言,它最大的优点是省时省力省钱。

为什么说它省时省力省钱呢?因为Deepfake是一项开源算法,经过了几年的迭代,已经有了许多成熟的系统化使用方法,其学习成本是相对比较低的。另外用Deepfake算法只需要去学习一些演员年轻时的作品,而不需要演员佩戴动捕设备,进行更多的额外拍摄。考虑到实际的拍摄效率,预算,以及技术难度后,Deepfake也就成了最好的选择。

国外已经出现过很多通过Deepfake进行诈骗的案例,比如2022年,犯罪集团通过合成马斯克的视频,推出了一个叫BitVex的比特币诈骗平台,短短半年时间骗取总额高达3000万美元。除了诈骗外,还有一些公司用Deepfake技术生成虚拟人物,来做虚假销售账户,以不正当的方式进行竞争;在国外选举期间,网络上也会出现大量用Deepfake技术生成的虚假政治视频,引导选举的舆论方向;还有一些犯罪分子,通过Deepfake合成视频来对被害人进行敲诈勒索,或是打击报复的行为,某马来西亚政治家曾因一段涉嫌从事同性恋活动的影片而被判入狱,但后来证实影片是为Deepfake伪造。

图三:犯罪集团用Deepfake伪造的马斯克推行BitVex的视频

为了解决不断升级的Deepfake技术带来的隐私和安全问题,各方都在积极地采取措施,从2019年开始,各国、各平台就开始针对Deepfake出台一些新的保障政策,我国在2023年1月10新发布的《互联网信息服务深度合成管理规定》中也提到,提供智能对话、合成人声、人脸生成、沉浸式拟真场景等生成或者显著改变信息内容功能服务的,应当进行显著标识,并明确规定深度合成服务提供者和使用者不得利用深度合成服务制作、复制、发布、传播虚假新闻信息。

图四:《互联网信息服务深度合成管理规定》中对于深度合成的定义

2. ChatGPT检测

在上个月的巡山报告中,我们介绍了近几个月来爆火的ChatGPT。自从ChatGPT从2022年11月在OpenAI网站上作为免费应用程序推出以来,已经有数百万人使用过它。虽然很多人找到了使用该工具的无害方法,但是很多学生发现可以使用Chat’GPT轻松回答考试问题并协助完成其他工作。为了防止作弊和剽窃,许多大学已经修订考试、论文题目和诚信审查程序,也有一些学校和机构宣布禁止使用ChatGPT。

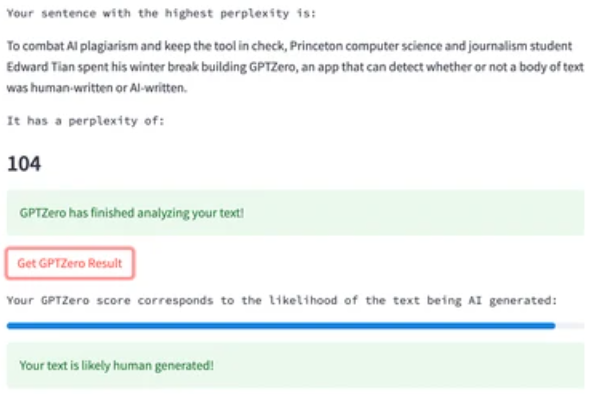

有一名计算机科学的学生Edward Tian开发了一个名叫”GPTZero”的app,可以检测文本是由人类写的还是由AI生成的,截至2023年1月6日,已经有超过16000人使用过该app。

开发者称,GPTZero考虑了文章的两个重要特征:迷惑性(perplexity)和突发性(burstiness)。迷惑性是指每个词由AI建议的可能性有多大,他认为人类会更倾向于随机使用词组,而突发性则是指每个句子的复杂程度,AI生成的每个句子复杂性都差不多,但人类会写出长短结合的表达,将一篇文章丢给GPTZero后,它会对这篇文章的这两个特征进行打分,如果两个特征得分都很高,则说明这篇文章是由人写的概率更高。

GPTZero的beta版只是基于简单的线性回归模型将这两个特征和一些其他特征(开发者并没有公布其他特征的细节)进行了训练,而v1版则是换成了一个逻辑回归模型。模型所用的训练数据是一些BBC新闻的文章和用这些文章相同的提示词(promt)由AI生成的文章,开发者声称v1版的假阳率(false positive rate)控制在了2%以内。

图五:GPTZero检测文本是否由ChatGPT生成

GPTZero的用户评价有好有坏,有人指出,GPTZero在一些议论文(essay)上的表现尤其不佳,会将大量由优秀作者书写的议论文标记为AI生成,小编猜想,这应该与GPTZero选取的特征和训练数据有关,优秀的议论文往往有严密的逻辑和严谨的用词,这可能会导致这些文章的迷惑性较低,另外新闻文章虽然是记录事实,但是通常含有一定的感情色彩,而议论文更多的是用事实和实验来论证观点,并不包含太多的个人情绪在内。

类似Tian这样研究如何辨别人类书写的文本和ChatGPT生成的文本的学者还有很多,针对对此问题,ChatGPT的开发团队OpenAI提出了一个解决方案:在ChatGPT生成的文章里添加“水印”。

当然,这里的水印可不是我们在图片或者视频中能一眼看出来的那种,而是指一种特定的文字规则,为此几位研究者在针对 ChatGPT 等语言模型输出的水印进行了深入研究后,提出了一种高效水印框架,水印的嵌入对文本质量的影响忽略不计,可以使用高效的开源算法进行检测,而无需访问语言模型的 API 或参数。

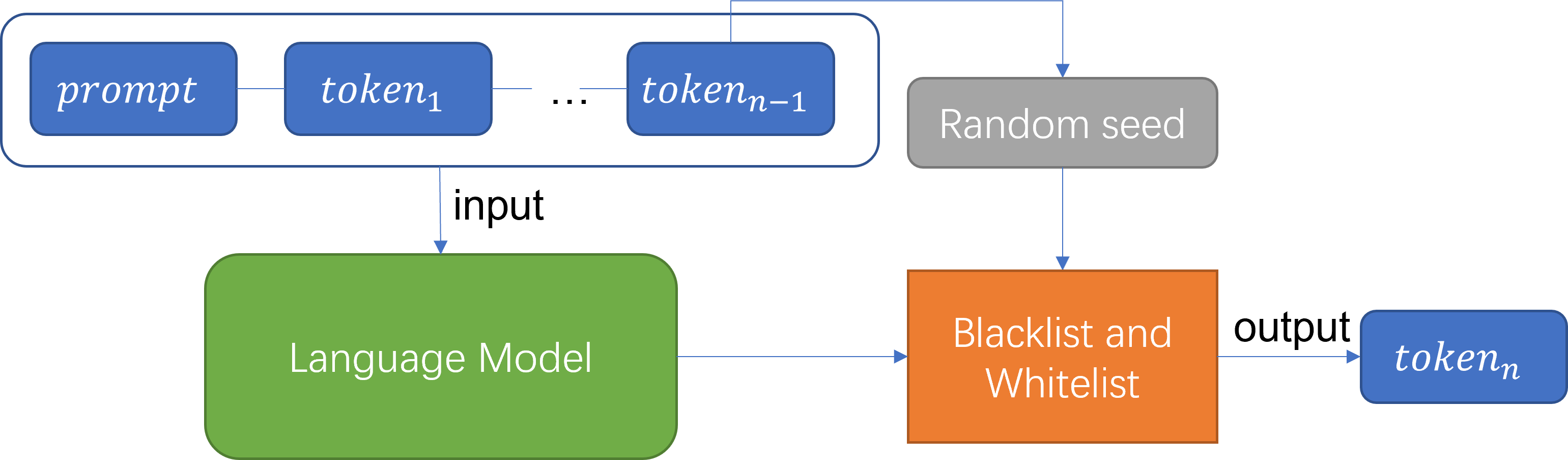

小编带大家简单回忆一下语言模型生成文本的过程,语言模型是通过依次生成一个一个词,从而组成一个句子的,而这些生成的词都在语言模型的词汇表(vocabulary)里。首先由外部输入一个提示词(prompt)作为起始,然后语言模型根据提示词,计算下一个词在词汇表中的概率分布,并根据分布预测下一个词。之后再根据提示词和先前已经生成的词来预测下一个词,直到整个句子结束。

而这个生成水印的算法是指,在每次生成新词的时,计算前一个词的哈希值,并将这个值作为一个随机种子,用这个种子将整个词汇表平均分成黑名单和白名单两部分。在生成下一个词时,只从白名单中选取,而不从黑名单中选取。

图六:通过黑名单规则的水印添加方法过程

举个例子,比如已知“我今天早上吃了”这句话,让模型预测下一个token,根据模型计算得到的概率分布,本来会在“面包”和“馒头”两个词中等可能地选取,但用“吃了”这个token作为随机种子切分整个词汇表后,“面包”在黑名单B而“馒头”在白名单W中,那么最后模型的输出一定是“我今天早上吃了馒头”。

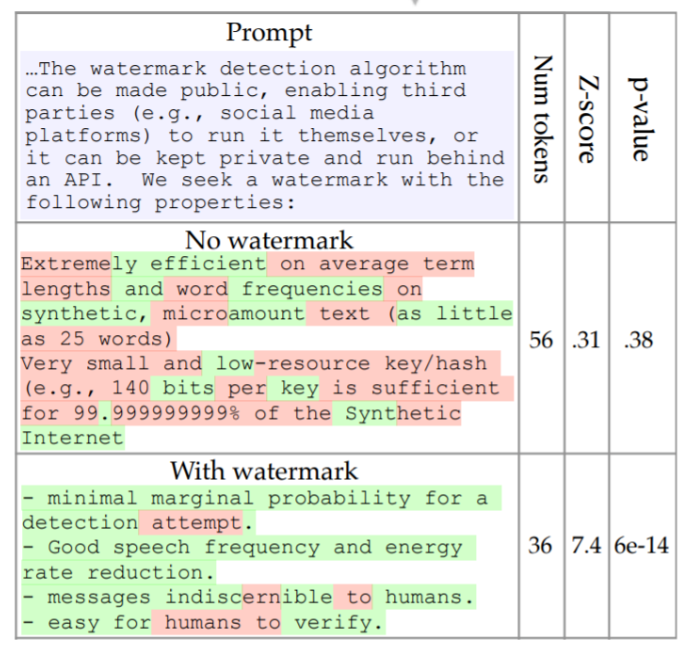

那么加了这种基于黑名单的水印后,要如何才能检测出来呢?这里就要用到统计学中的假设检验方法了。假设检验方法就是我们先对总体的特征提出一个假设H,然后根据抽样研究的统计推理,对此假设是否应该被拒绝做出推断。

对于一段文本,我们会计算这段文本中每个词的哈希值,将每个词的哈希值分别作为随机种子,并将整个词汇表分成黑白名单两部分后,再看下一个词是否在其黑名单中。如果文本的生成中没有使用水印技术,那么文本中的每个词在上一个词的黑名单和白名单中的概率应该是相同的,也就是整段文本中,违反黑名单的词的数量应该服从一个二项分布,期望等于文本中词的数量的一半。

图七:检测文本是否存在水印来判断是否是由AI生成的

上图是原作者给出的一个例子,这两段文本中,标记红色的词是指违反了黑名单规则的词,如果一段文本中大部分的词都没有违反黑名单,那么说明这段文本在生成时很有可能加入水印算法。通过假设检验的方法,原作者判断第二段文本是添加了水印的,判断出错的概率仅有0.000000000004%

当然,这种使用严格黑名单规则存在一个很大的缺陷,如果一段文本是低熵的(low entropy),那么生成的文本有可能会出现很明显的语义错误。什么是低熵的文本呢?意思就是这段文本后面的词很大程度上取决于提示词,整段文本的平均信息含量较少。换一种方式说,就是已知一些词后,下一个词只会以很高的概率在某个或某几个词中产生。比如用‘for(i=0;i‘作为提示词,那么整个句子就有极大的可能是一句编程语句,最后生成的文本有极大的可能就会是’for(i=0;i‘。又比如,以’Barack‘作为提示词,那么下一个生成的token为’Obama‘(Barack Obama,美国第44届总统)的概率几乎为1,而如果这时候’Obama‘恰好处在黑名单中,那么生成的文章可能就会有’Barack Trump‘这种荒谬的人名出现。

为此,作者们又在文章后半部分提出了一种“soft”的水印方式。这种方式最大的一点不同是,在模型生成文本的时候,它没有严格禁止黑名单中的词出现,而是提高白名单中每个词出现的概率,同时降低黑名单中每个词出现的概率,并且调整了黑白名单占整个词汇表的比例。但是这种方法需要增加参数来调整黑白名单中token出现概率和黑白名单的大小,检测过程也更加复杂。

该水印生成和检测方法目前还没有被OpenAI使用到ChapGPT中,小编觉得,目前各方都已经对大型语言模型在学术剽窃上的应用提起了重视,以后还会有越来越多更先进的方法来检测AI生成的文本,而用这些语言模型来进行不良行为的人,也会想办法训练AI生成更加难以被检测出来的文本,这还是一场AI之间的博弈。对此,你怎么看呢?

参考文献:

1、https://blog.csdn.net/t28383993/article/details/125806624

2、 https://zhuanlan.zhihu.com/p/564661269

3、https://www.vice.com/en/article/3admg8/a-compsci-student-built-an-app-that-can-detect-chatgpt-generated-text

4、https://gptzero.substack.com/p/gptzero-update-v1

5、https://www.theguardian.com/technology/2022/dec/31/ai-assisted-plagiarism-chatgpt-bot-says-it-has-an-answer-for-that

6、https://www.businessinsider.com/turnitin-will-detect-chatgpt-answers-openai-product-teachers-ai-speech-2023-1?amp=

7、https://arxiv.org/pdf/2301.10226v1.pdf