本期巡山报告,AI团队从视觉和听觉给大家带来两个新鲜玩意——CLIP和数字化的爱因斯坦。

一、CLIP

今年年初,OpenAI推出了最新一款AI视觉模型CLIP(Contrastive Language–Image Pre-training),经过庞大的数据集训练,CLIP在图文识别和融合上展现了惊人的表现力。例如,输入文本“震惊”,AI能够准确地通过“瞪眼”这一关键特征来呈现,并且再根据Text、Face、Logo等其他文本信息,将其融合成一张新图像。通过关键词理解描绘出一张新图像对于人类来讲可能不是什么难事,但对于AI来讲,则需要它具有极高的视觉识别和理解能力,包括文本识别和图像识别。因此,CLIP模型可以说代表了现有计算机视觉研究的最高水平。

然而,正是这个兼具图文双重识别能力的AI,却在一张“纸片”面前翻了车。怎么回事呢?

AI上当,“苹果”变 “iPod”

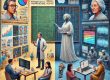

最近OpenAI研究团队做了一项测试:研究人员给CLIP输入了如下一张图:

AI不仅识别出了这是苹果,甚至还显示出了它的品种:Granny Smith。然而,当研究人员给苹果上贴上一张写着iPod的纸片,结果AI真的被误导了,如右图所示,其iPod的识别率达到了99.7%。这说明由于模型强大的文本读取能力,即使是手写文字的照片也会欺骗模型。这种欺骗实现起来很简单,只需纸笔即可,且影响显著。

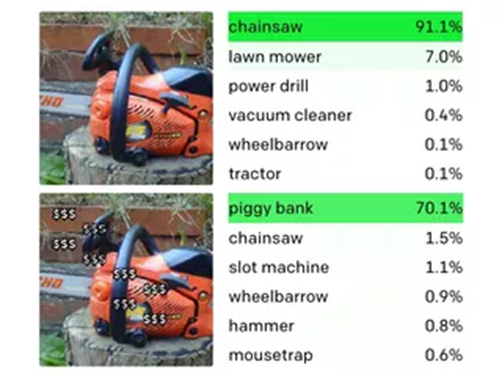

我们再来看一组案例:

图片上方,AI成功识别出了电锯(识别率91.1%)。但图片下方在电锯上覆盖了“$$$”字符后,AI就将其识别成了存钱罐(识别率70.1%)。

那么为什么会有这种现象呢?研究人员解释说,关键在于CLIP能够对以文本、符号或概念形式呈现的相同概念作出响应。简单来说,就是这个模型既能抓取图像信息,也能抓取文本和符号的信息,这可以说是一把双刃剑,一方面它可以实现对图文的高度控制,另一方面遍及文字、图像的神经元也让AI变得过于敏感,错失主要信息。由于技术还不够完善,所以目前还没有应用到现实生活中,但其前景还是可观的,比如无人驾驶汽车领域,就可能会用到这项技术。

二.数字化爱因斯坦

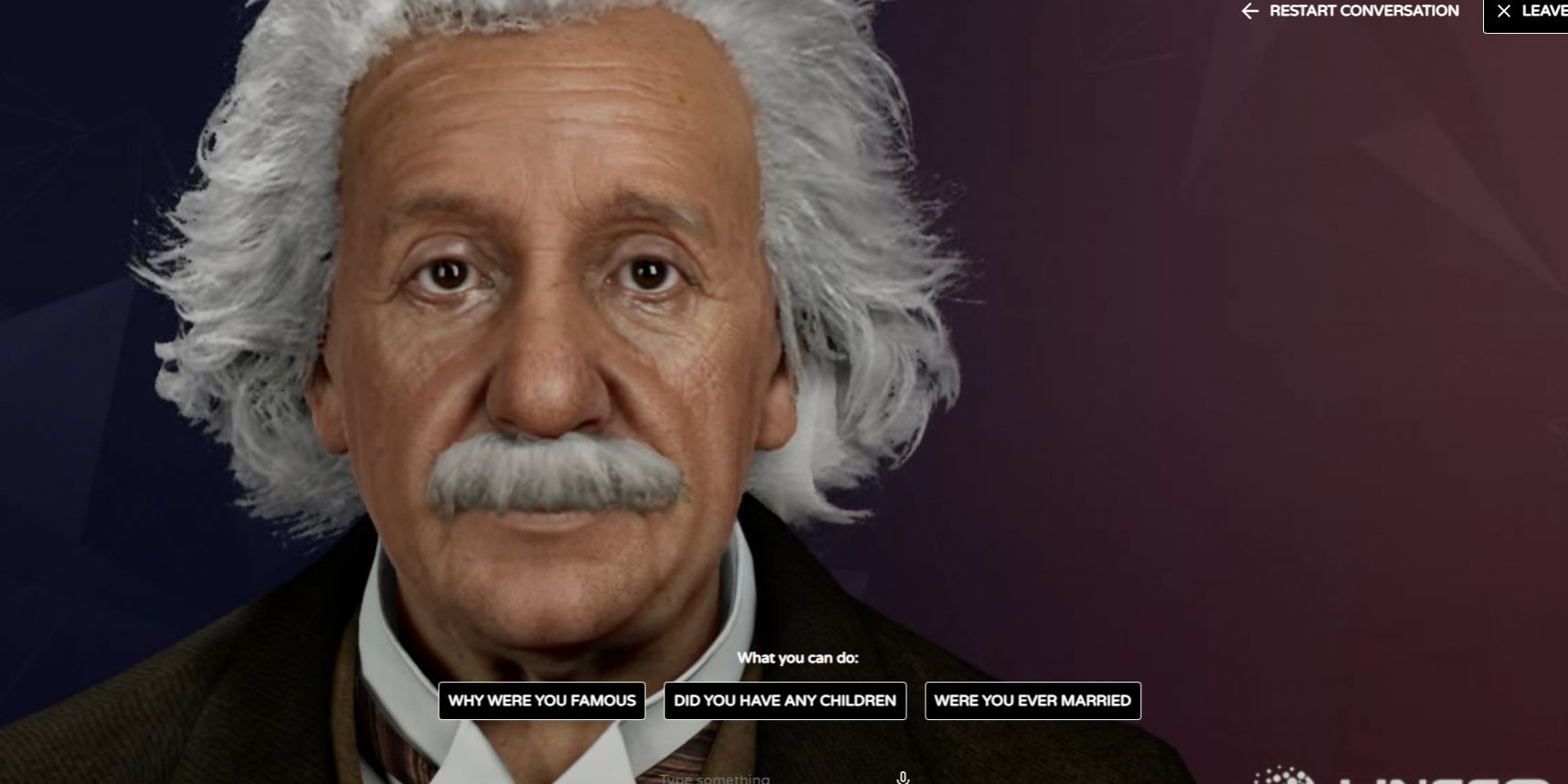

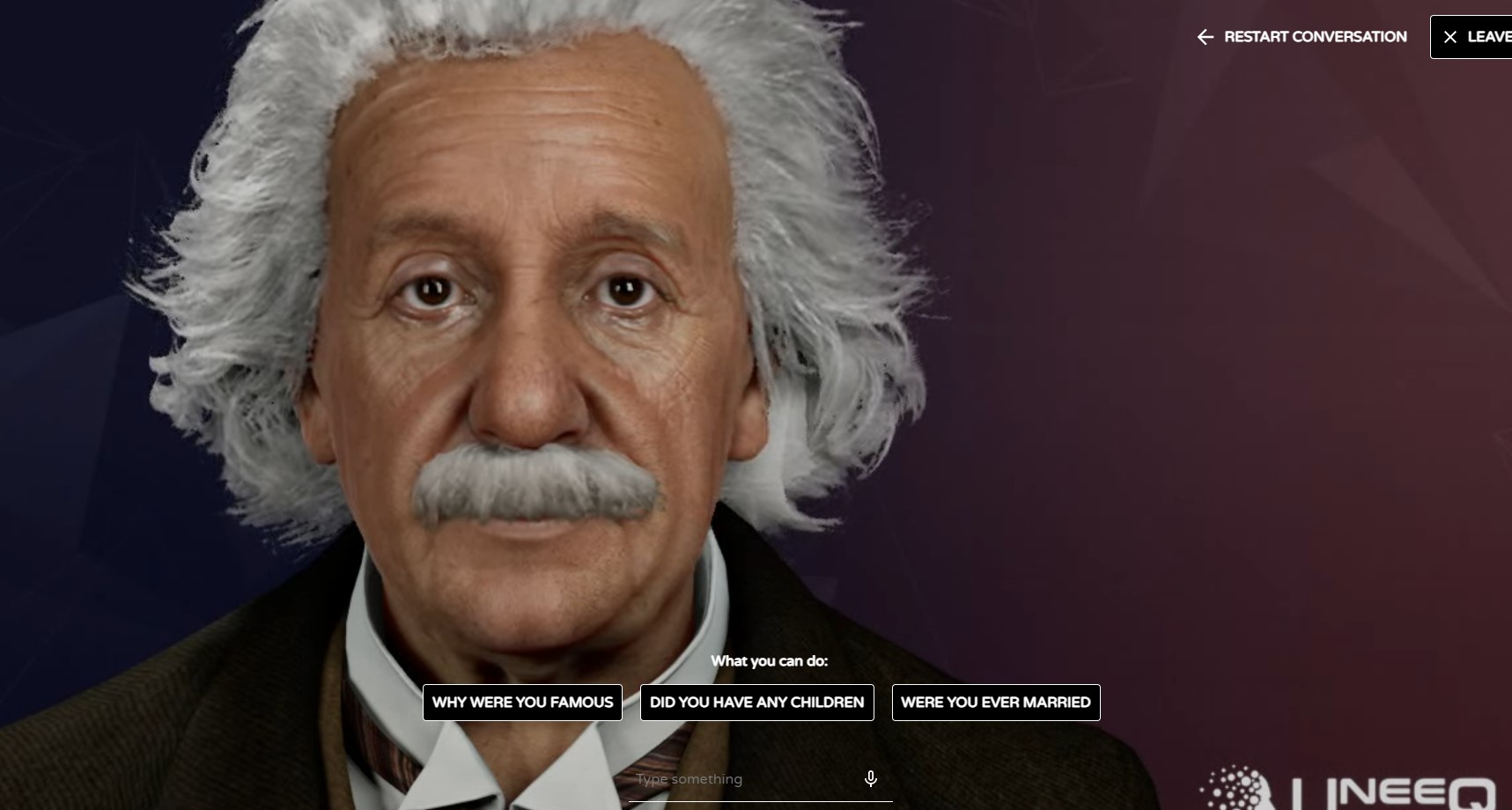

我们为什么喜欢电影?因为它能引导我们进入虚拟世界。在那些世界里,你可以观看维京人的战斗,或是见证宇航员前往不同星球。但这通常都是一个单向的体验——我们不能与电影中的人物互动。现在,情况有变!与合作伙伴UneeQ一起,Aflorithmic创造了一个数字化的阿尔伯特爱因斯坦。

一段时间以来,UneeQ一直致力于创造可以与之对话的数字化人类。由于爱因斯坦是一个广为人知的人物,一个真正的天才,并且很多人都想和他交谈,所以UneeQ最终选择了爱因斯坦。

但真正的爱因斯坦的声音是什么样子?

根据历史记录,爱因斯坦的声音有以下特点:

- 有很浓厚的德国口音

- 音调相当高

- 说话缓慢,睿智,听起来友好

然而,有一个严重的问题:爱因斯坦的录音质量很差,他的口音太重,难以理解,且录音数量很有限。如果使用这些数据,那么最终的结果会非常差。这时候我们回到一开始类比电影的地方:根据上面的特点,Aflorithmic设计了一个人们会认为是爱因斯坦的声音,也就是用一种观众容易理解的方式来塑造他,就像观众会想历史电影中的人物会怎样说现代英语。

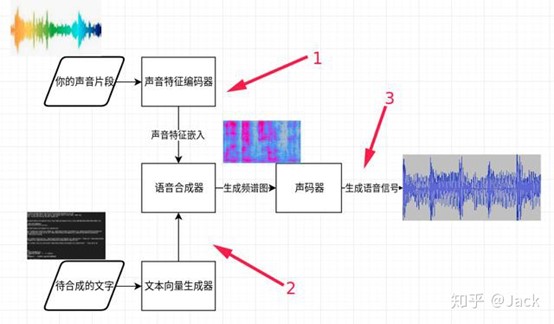

具体实现分三个阶段训练:

- 训练声音特征编码器——提取待克隆的声音特征

- 训练语音合成器——提取待合成文字向量

- 训练声码器——语音合成

但是,要使数字化爱因斯坦发挥作用,还有一个关键步骤:他必须能在很短的时间内回复,这样这种体验才能真正感觉像是一次对话。通过改进一些模型的参数,他们缩小了从计算知识引擎到其API能够呈现语音回复之间的回复时间,爱因斯坦的回复时间从12秒降低到了3秒以下,这近乎接近了实时的回复。

数字化爱因斯坦真正展示了对话式人工智能的发展方向,并远远超出了聊天机器人或客户服务的范畴:教育可以变得更具吸引力,社交商务将帮助客户找到最适合其需求的产品,甚至孤独和治疗也可以被对话式人工智能彻底改变。语音克隆在其中起着重要作用。

相关文章:

[1].https://www.leiphone.com/category/industrynews/Re8Bwh0m4lEmqOUV.html

[2].CreatingEinstein’s Voice – Aflorithmic

[3].声音克隆技术简介- 知乎 (zhihu.com)

[4].https://techcrunch.com/2021/04/16/ai-driven-audio-cloning-startup-gives-voice-to-einstein-chatbot/